netzpolitik.org

Bitte aktualisieren Sie PHP auf Version 8.2.0 (zurzeit: 8.1.2-1ubuntu2.23). Info

Ein halbes Jahr lang hat sich Pornhub den britischen Alterskontrollen gebeugt und massenhaft Nutzer*innen überprüft. Jetzt macht der Konzern eine Kehrtwende und kündigt seinen Rückzug aus dem Vereinigten Königreich an. Dahinter steckt ein geschickter PR-Stunt. Die Analyse.

Seit dem 25. Juli vergangenen Jahres müssen im Vereinigten Königreich Apps und Websites das Alter ihrer Nutzer*innen kontrollieren, falls es dort pornografische Inhalte zu sehen gibt. So verlangt es der Online Safety Act, den die britische Medienaufsicht Ofcom durchsetzt.

Ein halbes Jahr lang ist Pornhub, eine der meistbesuchten Websites der Welt, diesen Regeln gefolgt. Um zu beweisen, dass sie schon erwachsen sind, mussten sich britische Nutzer*innen etwa über eine Kreditkarte oder ihren Mobilfunkanbieter verifizieren lassen. Doch damit soll bald Schluss sein.

Wie Pornhubs Mutterkonzern Aylo nun bekanntgab, wird die Plattform am 2. Februar für britische Nutzer*innen dichtmachen. Die Ausnahme sind diejenigen, die vor dem Stichtag bereits einen Account angelegt hatten. Das gleiche gilt für die kleineren Schwesterseiten Redtube und YouPorn.

Zur Begründung schreibt der Konzern, das britische Gesetz habe sein Ziel verfehlt, den Zugang Minderjähriger zu Inhalten für Erwachsene einzuschränken. Die Erfahrung nach sechs Monaten habe das gezeigt. Weiter heißt es auf Englisch:

Wir können innerhalb eines Systems, das unserer Ansicht nach sein Versprechen des Jugendschutzes nicht einlöst und sogar gegenteilige Auswirkungen hatte, nicht weiter operieren. Wir sind der Auffassung, dass dieses Regelwerk in der Praxis den Datenverkehr in dunklere, unregulierte Bereiche des Internets verlagert und zudem die Privatsphäre sowie die persönlichen Daten von Bürger:innen des Vereinigten Königreichs gefährdet hat.

Pornhub spielt damit auf gleich drei Punkte an, die Kritiker*innen von Alterskontrollen häufig ins Feld führen.

- Erstens, dass neugierige Kinder und Jugendliche ihre Recherche nach sexuellen Inhalten nicht beenden, wenn sie bei populären Pornoseiten auf eine Alterskontrolle stoßen – sondern diese Hürde entweder mit Tools wie VPN-Diensten überwinden oder auf andere Seiten ausweichen.

- Zweitens, dass strenge Alterskontrollen generell Nutzer*innen zu weniger regulierten Angeboten mit möglicherweise weniger Inhaltsmoderation locken.

- Und drittens, dass sich durch Alterskontrollen Berge sensibler Daten anhäufen können; verlockend sowohl für Kriminelle als auch für staatliche Überwachung.

Künstliche Verknappung

Neu ist diese Kritik nicht, auch nicht für Pornhub. Auf Grundlage dieser Argumente hätte die Plattform von Anfang an die Alterskontrollen im Vereinigten Königreich zurückweisen können. Zum Vergleich: In mehreren US-Bundesstaaten hat die Plattform ihre Geschäfte eingestellt statt Kontrollen einzuführen.

Die jetzige Kehrtwende nach sechs Monaten britischer Alterskontrollen legt nahe, dass Aylo einen PR-Stunt hinlegt. Besonders ins Auge fällt die Ankündigung, dass Brit*innen die Plattform weiter nutzen können, sofern sie bis 2. Februar einen Account anlegen. Diese von Aylo selbst gewählte Frist ist künstliche Verknappung – also eine bewährte Marketing-Strategie. Droht ein landesweiter Aufnahme-Stopp neuer Nutzer*innen, dürften sich viele vorher noch schnell einen Account anlegen, für alle Fälle.

Was Aylo nicht weiter ausführt: Auch ohne Account dürften britische Nutzer*innen künftig Pornhub erreichen können, wenn sie ihre britische IP-Adresse verschleiern, zum Beispiel per VPN oder Tor-Netzwerk.

Mehrfach verknüpft Aylo in seinem Blogbeitrag valide Argumente mit eigenen Konzerninteressen. So warnt Aylo ausdrücklich vor Pornoseiten, die keine Alterskontrollen durchführen, Uploader*innen nicht verifizieren, Inhalte nicht moderieren – und dennoch auftauchen, wenn Brit*innen nach „free porn“ googeln. Im Kontrast dazu kann sich Pornhub selbst als vorbildlich inszenieren und schreibt in polierter PR-Prosa von seiner „Bibliothek vollständig moderierter, einvernehmlicher Erwachsenen-Unterhaltung“.

In der Tat hat die Plattform inzwischen umfassende Richtlinien eingeführt, um Uploader*innen und Inhalte zu prüfen. Geschehen ist das allerdings erst nach jahrelangen Skandalen zu laxen Kontrollen und nicht-einvernehmlichen Aufnahmen auf der Plattform – was Aylo an dieser Stelle unerwähnt lässt. Früher hatte sich Pornhub mit diesen Maßnahmen mühsam aus einer internationalen Image-Krise herausgearbeitet; heute verkauft die Plattform es als Alleinstellungsmerkmal.

Strategie: Flucht nach vorn

Inzwischen wählt Pornhub wiederholt die Flucht nach vorn als Strategie. Klar erkennbar ist das spätestens seit 2023, als Pornhub die eigenen Krisen in der Netflix-Doku „Money Shot“ aufarbeiten ließ – und sich dabei fast nebenbei als Stellvertreter der gesamten Branche überhöhte.

Während Regierungen und Aufsichtsbehörden weltweit Druck mit verschärften Alterskontrollen machen, erprobt Pornhub-Mutter Aylo unterschiedliche Reaktionen. Augenscheinlich lotet der Konzern dabei die eigenen Optionen aus. So hatte Pornhub auch in Frankreich feierlich eine freiwillige Selbst-Sperre verkündet; das war im Juni 2025.

Derweil sind Sperren in Deutschland kein Thema, wobei es hierzulande ähnlich strenge Pflichten für Alterskontrollen gibt. Stattdessen streitet sich Pornhub seit Jahren mit der deutschen Medienaufsicht vor Gericht. Noch vor wenigen Monaten hatte Pornhub auf Anfrage von netzpolitik.org zumindest Bereitschaft signalisiert, in der EU Ausweise zu kontrollieren.

Ruf nach Jugendschutz auf Geräte-Ebene

Den prominenten Appell für einen strategischen Umgang von Pornoseiten mit kommender Regulierung gab es bereits im Jahr 2022, und zwar durch den Unternehmer Fabian Thylmann. Er ist ehemaliger Geschäftsführer des Aylo-Vorgängers Manwin. Im Gespräch mit dem Bayerischen Rundfunk sagte Thylmann damals, es brauche strenge Gesetze für Pornoseiten und der Pornhub-Mutterkonzern solle mitwirken. Dahinter steckt ein simples Kalkül: Wenn eine Regulierung nicht mehr zu vermeiden ist, dann können sich große Plattformen ihre Vormachtstellung sichern, indem sie aktiv mitmachen und mitbestimmen.

Genau das versucht Aylo offenbar heute. So betont Aylo: „Wir bleiben der Zusammenarbeit mit dem Vereinigten Königreich, der Europäischen Kommission und anderen internationalen Partnern verpflichtet.“ Den geplanten Rückzug aus dem Vereinigten Königreich verbindet der Konzern mit einer klaren netzpolitischen Forderung. Demnach sollten alle Smartphones, Tablets und Computer zuerst in einem Kinderschutz-Modus ausgehändigt werden, der bekannte Websites für Erwachsene ab Werk blockiert.

Diese Forderung nach Jugendschutz auf Geräte-Ebene anstelle von Alterskontrollen hat Aylo bereits wiederholt vorgebracht. Auf etwaige Bedenken zu den Fallstricken von Filtersystemen für Jugendliche geht der Konzern an dieser Stelle nicht ein.

Der Kurs, den nicht zuletzt die Europäische Union etwa mit der Richtlinie für audiovisuelle Mediendienste (AVMD-RL) und dem Gesetz über digitale Dienste (DSA) beim Jugendschutz einschlägt, geht ohnehin in eine andere Richtung. Großflächige Ausweiskontrollen scheinen vor allem politisch gewollt zu sein. Statt Pornoseiten stehen in der aktuellen Debatte derzeit insbesondere Social-Media-Seiten im Fokus, während Kinder und Jugendliche auch jenseits davon eine Vielzahl an Risiken im Netz erleben.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Mit einem Phishing-Angriff versucht ein bislang unbekannter Akteur, offenbar gezielt Zugriff auf die Signal-Konten von Journalist:innen und Aktivist:innen zu bekommen. Wir erklären, wie der Angriff funktioniert und wie man sich vor ihm schützen kann.

In den letzten Tagen und Wochen wurden nach Informationen von netzpolitik.org vermehrt Journalist:innen mit einer bekannten Phishing-Attacke auf dem Messenger Signal angegriffen. Betroffen sind nach Kenntnis von netzpolitik.org dutzende (investigative) und teilweise prominente Journalist:innen bei öffentlich-rechtlichen Fernsehsendern sowie mehreren großen und kleinen Medienhäusern, darunter die Zeit, Correctiv, Euractiv und netzpolitik.org. Hinzu kommen einzelne bekannte Vertreter:innen der Zivilgesellschaft, darunter auch Rechtsanwälte.

Netzpolitik.org hat im Zusammenhang mit dem Angriff bislang keine Betroffenen gefunden, die nicht diesen Kategorien zuzuordnen sind. Das deutet auf einen gezielten Phishing-Angriff auf bestimmte Telefonnummern hin, ist aber kein Beweis für einen solchen.

„Wir haben erste Anzeichen dafür gesehen, dass Journalist:innen, Politiker:innen und Mitglieder der Zivilgesellschaft in Deutschland und ganz Europa ins Visier genommen wurden“, bestätigt Donncha Ó Cearbhaill, Leiter des Security Labs von Amnesty International gegenüber netzpolitik.org.

„Diese Signal-Phishing-Kampagne scheint sehr aktiv zu sein“, so Ó Cearbhaill weiter. Es sei unklar, wie oft die Angriffe erfolgreich seien, aber die Ausbreitung der Kampagne würde wahrscheinlich durch die Kontaktlisten auf Signal angeheizt, die von früheren Opfern gesammelt würden.

Wie geht der Angriff?

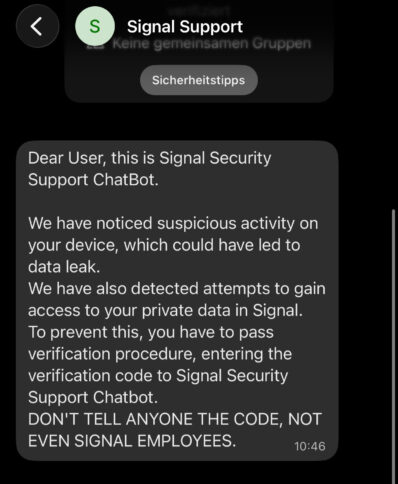

Bei dem Angriff verschicken die Angreifer eine Nachricht über den Messenger Signal, bei der sie sich als „Signal Support“ ausgeben und behaupten, dass es verdächtige Aktivitäten auf dem Handy sowie den Versuch gegeben habe, auf private Daten zuzugreifen. Deswegen müssten die Betroffenen den Verifikationsprozess von Signal erneut durchlaufen und den Verifikationscode dem vermeintlichen „Signal Security Support ChatBot“ übermitteln. Die ersten netzpolitik.org bekannten Betroffenen des Angriffs wurden im November kontaktiert, erste Berichte über die Angriffsversuche gab es im Oktober von Citizen-Lab-Forscher John Scott-Railton.

In der Anfrage des gefälschten Support-Accounts heißt es auf englisch:

Dear User, this is Signal Security Support ChatBot. We have noticed suspicious activity on your device, which could have led to data leak. We have also detected attempts to gain access to your private data in Signal. To prevent this, you have to pass verification procedure, entering the verification code to Signal Security Support Chatbot. DON’T TELL ANYONE THE CODE, NOT EVEN SIGNAL EMPLOYEES.

Wird diese Chatanfrage angenommen, bekommt der Angegriffene eine SMS mit einem Verifikationscode auf sein Handy geschickt, wie ein Betroffener gegenüber netzpolitik.org bestätigte. Das ist offenbar ein echter Verifikationscode von Signal. Das weist darauf hin, dass sofort nach Annahme der Chatanfrage von den Angreifenden versucht wird, einen Account unter der Handynummer neu zu registrieren.

Alles netzpolitisch Relevante

Drei Mal pro Woche als Newsletter in deiner Inbox.

Gibt man diesen Code an den falschen „Signal Support“ weiter, können die Angreifer einen neuen Account registrieren. Signal-Accounts sind zusätzlich mit einer Signal-PIN geschützt, die neben der SMS ein zweiter Sicherheitsfaktor ist. Wenn die Angreifer diese PIN nicht kennen, sehen sie weder Kontakte, noch Gruppen oder Inhalte.

Würde man jedoch die Signal-PIN an die Angreifer weitergeben, können sie Profil und Kontakte sehen. Sie sehen zwar nicht die vergangenen Chats, können aber dann den ehemaligen Nutzer aus seinem Account ausschließen, indem sie die Signal-PIN ändern und dann die Registrierungssperre aktivieren. Damit wäre es Angreifenden möglich, den Account dauerhaft zu übernehmen – andere Nutzer:innen in Chats oder Gruppen bekommen maximal mit, dass sich die Sicherheitsnummer geändert hat.

Mögliches Ziel: Politische Netzwerke und Quellen ausspähen

Es lassen sich dann Chatgruppen mitlesen und die Kontakte und Netzwerke der Betroffenen ermitteln. Im Falle von Journalist:innen könnten dadurch zum Beispiel Quellen offengelegt werden, die verschlüsselt mit den Journalist:innen kommunizieren. Bei Aktivist:innen könnten politische Netzwerke und Kontakte offenbart werden. Im Zuge einer dauerhaften Account-Übernahme kann der Angreifer zudem alle ab der Übernahme auflaufenden Kommunikationsinhalte mitlesen.

Keiner der netzpolitik.org bekannten Betroffenen ist weiter gegangen, als den Chat anzunehmen und die Verifikations-SMS geschickt zu bekommen.

Wer hinter dem Angriff steckt, lässt sich mit den vorliegenden Informationen nicht sagen. Ein Angreifer mit Überwachungszugriff auf Mobilfunknetze könnte jedoch die per SMS verschickten Verifizierungscodes selbst auslesen und müsste sie nicht erfragen. Um vollen Zugriff auf den Account zu erlangen, müsste auch er die Signal-PIN abfragen.

Wie kann man sich schützen?

„Diese Angriffe nutzen keine Schwachstelle in der Signal-Anwendung selbst aus. Signal ist nach wie vor eine der sichersten und am weitesten verbreiteten verschlüsselten Messaging-Apps“, sagt Donncha Ó Cearbhaill, Leiter des Security Lab bei Amnesty International.

Von Signal selbst heißt es gegenüber netzpolitik.org: „Signal wird Sie niemals in irgendeiner Form über einen Zwei-Wege-Chat innerhalb der App kontaktieren.“ Zudem sollten die Nutzer:innen die Registrierungssperre aktivieren. Das geht unter „Einstellungen“ –> „Konto“ und dann den Schieberegler bei „Registrierungssperre“ aktivieren. Zudem sagt Signal: „Geben Sie Ihre Signal-PIN oder Registrierungssperre niemals an Dritte weiter.“

Wenn eine Nachricht eines bislang unbekannten Accounts mit dem beschriebenen oder einem ähnlichen Inhalt ankommt, sollte man die ankommende Nachricht „melden“ und dann „melden und blockieren“ klicken. In keinem Fall sollte man den Anweisungen folgen, weil Signal niemals Nutzer:innen auf einem solchen Weg kontaktieren würde.

Sollte in Chats die Nachricht auftauchen, dass sich die Sicherheitsnummer eines Kontakts geändert hat, bedeutet das häufig nur, dass dieser ein neues Handy hat. Dennoch sollte man immer in solchen Situationen auf einem anderen Kanal als dem Signal-Textchat bei dem betreffenden Kontakt nachfragen, warum sich dessen Sicherheitsnummer geändert hat.

Für die Überprüfung eignet sich in der Regel ein Telefonat oder noch besser ein Videotelefonat. Ratsam ist zudem, sich alle mit Signal verbundenen Devices anzeigen zu lassen und nicht mehr benötigte zu löschen.

Wenn du Ziel dieses Angriffs geworden bist, Zugriff auf deinen Signal-Account auf diese Weise verloren hast oder weitergehende Informationen und Hinweise zu diesem Angriff hast, wende Dich vertrauensvoll an uns für weitere Nachforschungen und Recherchen.

Update 28.1. – 12:29 Uhr:

Bei der Nennung der betroffenen Medien Euractiv hinzugefügt.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Microsoft hat auf dem Rechner einer österreichischen Schülerin ohne deren Zustimmung Tracking-Cookies installiert und so persönliche Daten abgegriffen. Die österreichische Datenschutzbehörde hat nun festgestellt, dass der Datenabfluss illlegal war. Auch andere Microsoft-Nutzende können von illegalen Microsoft-Cookies betroffen sein.

In vielen Schulen arbeiten Schüler*innen mit dem Softwarepaket Microsoft 365 Education. Doch das spielt scheinbar rechtswidrig Tracking-Cookies aus. Damit steht die Nutzung von Microsoft 365 Education – womöglich sogar aller Microsoft-365-Produkte – in der EU generell in Frage.

Die österreichische Datenschutzbehörde entschied im Fall einer Schülerin, die Microsoft 365 Education über einen Browser nutzte. Dabei installierte Microsoft ohne Wissen und Zustimmung der Schülerin fünf Tracking-Cookies auf deren Gerät. Wie ein Netzwerk-Mitschnitt belegt, wurden nachfolgend persönliche Informationen der Schülerin an Microsoft gesendet. Und das obwohl die Schülerin zuvor in den Datenschutzeinstellungen wo immer möglich die Datenübermittlung abgelehnt hatte.

Die Datenschutzbehörde hat Microsoft nun aufgefordert, das Tracking der Beschwerdeführerin innerhalb von vier Wochen einzustellen. Sollte Microsoft nicht einlenken, sind Geldstrafen möglich. Die Verbraucherschutzorganisation noyb, die die zugrundeliegende Beschwerde bei der Datenschutzbehörde eingereicht hatte, geht allerdings davon aus, dass Microsoft vor das österreichische Bundesverwaltungsgericht zieht.

Max Schrems von noyb sagt: „Unternehmen und Behörden in der EU sollten konforme Software verwenden. Microsoft hat es erneut versäumt, die gesetzlichen Vorschriften einzuhalten.“

Die Verantwortung von Microsoft

Die Cookies wurden 2023 gefunden. 2024 hat die Schülerin gemeinsam mit der NGO noyb Beschwerden darüber bei der Schule, der Schulbehörde und bei Microsoft eingereicht. Microsoft erklärte laut noyb daraufhin, dass die Schulen, die Microsoft 365 Education einsetzen, selbst für den Datenschutz zuständig seien.

In der zugrundeliegenden Beschwerde schreibt noyb, dass es problematisch sei, wie die Verantwortung für die Datenverarbeitung in den Microsoft-Verträgen geregelt sei: „Für die betroffenen Personen führt dies zu Situationen, in denen der vermeintliche ‚Auftragsverarbeiter‘ (hier: Microsoft) nicht auf die Ausübung der Rechte aus der DSGVO reagiert, während der vermeintliche ‚Verantwortliche‘ (hier: die Schule) nicht in der Lage ist, solchen Anfragen nachzukommen.“

2025 hatte die Datenschutzbehörde sich schon einmal mit dem Fall beschäftigt und festgestellt, dass Schule, Schulbehörde und Microsoft die Schülerin über die Datenerhebung hätten informieren und umfassend auf eine Anfrage der Schülerin nach den erhobenen Daten antworten müssen.

Microsoft-Cookies auch bei Erwachsenen problematisch

Der aktuelle Beschluss beschäftigt sich nun konkret mit den Tracking-Cookies, die Microsoft auf dem Gerät der Schülerin installierte. Solche Cookies schneiden das Nutzungsverhalten mit, identifizieren Nutzende eindeutig und werden oft zum Ausspielen von Werbung genutzt.

Laut noyb hat Microsoft gegenüber der österreichischen Datenschutzbehörde versucht, die EU-Tochtergesellschaft in Irland für zuständig zu erklären. Dort werden EU-Datenschutzbestimmungen kaum durchgesetzt. Doch die Datenschutzbehörde stellte fest, dass die relevanten Entscheidungen in den USA getroffen werden.

Weil das unautorisierte Tracking nicht nur bei Minderjährigen illegal ist, geht noyb davon aus, dass die Nutzung von Microsoft 365 auch bei erwachsenen EU-Usern juristische Probleme aufwirft. Tracking erscheine auch in Microsoft 365, also der gewöhnlichen Office Suite, wahrscheinlich, wenn dies selbst bei Minderjährigen in Microsoft 365 Education stattfinde. Die deutschen Datenschutzbehörden hatten bereits 2022 festgestellt, dass Microsoft 365 nicht DSGVO-konform betrieben werden kann.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Per Mausklick lassen sich Fotos bekleideter Personen in Nacktbilder verwandeln. Die Organisation AlgorithmWatch bittet nun um Hinweise auf solche Apps und Websites, um systematisch dagegen vorzugehen. Wie das klappen soll, erklärt Forschungsleiter Oliver Marsh im Interview.

Aus der Nische in die Newsfeeds: nicht-einvernehmliche, sexualisierte Deepfakes verbreiten sich zunehmend, nicht nur durch den kaum regulierten Chatbot Grok des rechtsradikalen Multi-Milliardärs Elon Musk.

Bereits im Jahr 2022 berichteten wir über teils populäre Apps, mit denen sich beliebige Gesichter auf die Körper von Pornodarsteller*innen montieren ließen. Nur wenige Jahre später waren die technischen Möglichkeiten ausgereifter, und offen zugängliche Shops boten an, Kleider in beliebigen Fotos durch nackte Haut zu ersetzen.

Wer solche Aufnahmen ohne Einvernehmen erstellt, übt digitale Gewalt aus. Jüngst hat die Debatte besonders Fahrt aufgenommen, weil massenhaft nicht-einvernehmliche, sexualisierte Deepfakes von Grok über den Twitter-Nachfolger X ein breites Publikum fanden.

Mithilfe von EU-Gesetzen will die gemeinnützige Organisation AlgorithmWatch nun etwas gegen das Phänomen unternehmen – und bittet Interessierte um Unterstützung. Was genau der NGO helfen würde, erklärt Tech-Forschungsleiter Oliver Marsh. Das Interview wurde aus dem Englischen übersetzt.

Internationale Netzwerke aus Deepfake-Anbietern

netzpolitik.org: Oliver, Warnungen vor der Gefahr durch nicht-einvernehmliche, sexualisierte Deepfakes gibt es schon länger. Welche Bedeutung hat das Phänomen heute?

Oliver Marsh: Eine große. Es ist bedauerlich, dass es erst ein Ereignis wie die aktuellen Vorfälle rund um Grok geben musste, bevor auch Aufsichtsbehörden und Regierungen das Problem als „dringend“ einstufen. Hoffentlich führt diese Dringlichkeit auch zu ernsthaftem Handeln, nicht nur auf Social-Media-Plattformen. Wir sollten uns fragen, was geschehen muss, um die Vielzahl der beteiligten Unternehmen in die Pflicht zu nehmen, darunter auch Anbieter großer Sprachmodelle. Sie müssen das Problem gemeinsam mit Regulierungsbehörden und Fachleuten angehen.

netzpolitik.org: Welche Unternehmen spielen eine Schlüsselrolle bei den Deepfakes?

Oliver Marsh: Dahinter steckt ein internationales Netzwerk aus Anbietern für Deepfake-Tools. Das Ökosystem betrifft auch große Plattformen. Auch ohne Grok hatte X bereits große Probleme mit nicht-einvernehmlicher Sexualisierung, etwa durch Netzwerke von Accounts, die dort Deepfake-Werkzeuge bewerben. Weitere Recherchen haben solche Probleme auch bei den Meta-Plattformen Facebook und Instagram gefunden, auf den App-Marktplätzen von Google und Apple und in der Google-Suche.

Auch Plattformen wie Reddit, Telegram und Discord werden genutzt, um Werkzeuge für Deepfakes zu verbreiten. Dort kursieren auch Tipps, wie Nutzende die Schutzmechanismen von weit verbreiteten Chatbots umgehen können, um solche Inhalte zu generieren. Und natürlich treiben Konzerne wie OpenAI, Google, Meta und Microsoft mit ihren KI-Anwendungen die Technologie voran, mit der sich nicht-einvernehmliche Inhalte einfacher erstellen lassen.

netzpolitik.org: Wie würde es konkret aussehen, wenn große Tech-Unternehmen erfolgreich gegen solche Deepfakes vorgehen?

Oliver Marsh: Die Plattformen würden sich zum Beispiel gegenseitig über entdeckte Accounts informieren, die solche Werkzeuge bewerben. Außerdem würden sie Aufsichtsbehörden und Fachleuten Informationen zur Verfügung stellen, damit sie das Problem weiter erforschen und etwas dagegen tun können. Genau so etwas ist bereits vor rund zehn Jahren geschehen, als Plattformen gemeinsam gegen Desinformation durch Accounts vorgegangen sind, die sich mit hoher Wahrscheinlichkeit der russischen Propaganda-Agentur „Internet Research Agency“ zuordnen ließen. In jüngerer Zeit ergreifen Plattformen jedoch weniger Initiative für solche Vorhaben.

Bisher nur wenige Hinweise eingegangen

netzpolitik.org: Per Online-Formular bittet ihr gerade die Öffentlichkeit um Hinweise auf Apps und Websites, mit denen sich nicht-einvernehmliche Deepfakes erstellen lassen. Warum?

Oliver Marsh: Über das Formular möchten wir jegliche Informationen sammeln, die uns dabei helfen, Posts, Accounts und Apps zu finden, die Menschen zu Werkzeugen für nicht-einvernehmliche Sexualisierung führen. Unser Fokus liegt auf den Meta-Plattformen Facebook und Instagram, auf X, dem Google Play Store und dem Apple App Store. Nützliche Hinweise sind zum Beispiel Stichwörter und Accounts, die wir auf den Plattformen suchen können.

netzpolitik.org: Wie gut klappt das mit den Hinweisen?

Oliver Marsh: Das Formular ist bereits seit Mitte vergangenen Jahres online. Bisher haben wir nur eine Handvoll Einreichungen erhalten; einige davon enthielten Hinweise auf mehrere Apps und Websites. Wir machen uns aber auch selbst auf die Suche und haben – was am meisten hilft – Partner in Journalismus und Forschung, mit deren Unterstützung wir unsere Datenbank erweitern können.

netzpolitik.org: Was genau macht ihr am Ende mit den entdeckten Posts, Accounts und Apps?

Oliver Marsh: Es ist äußerst schwierig, dafür zu sorgen, dass solche Inhalte ganz aus dem Netz verschwinden. Wir wollen die Verbreitung nicht-einvernehmlicher, sexualisierter Deepfakes jedoch einschränken. Unser Projekt soll vor allem prüfen, ob wir sehr große-Online Plattformen (VLOPs) mithilfe des Gesetzes über digitale Dienste (DSA) dazu bringen können, das Problem effektiv anzugehen.

netzpolitik.org: Der DSA verpflichtet Plattformen nicht nur dazu, einzelne gemeldete Inhalte zu prüfen. Sehr große Plattformen müssen auch generell einschätzen, welche systemischen Risiken von ihnen ausgehen und dagegen Maßnahmen ergreifen.

Oliver Marsh: Ja, unsere Hoffnung ist, dass sehr große Online-Plattformen selbst aktiv werden, und Posts über solche Werkzeuge sowie nicht-einvernehmlich erzeugte Bilder eindämmen. Immerhin sind sie es, die ein riesiges Publikum haben und neue Nutzende damit in Kontakt bringen könnten.

Hoffnung auf Durchsetzungswillen der EU

netzpolitik.org: Seit der Machtübernahme der rechtsradikalen Trump-Regierung stößt Tech-Reglierung aus der EU bei US-Anbietern auf vehemente Gegenwehr. Andererseits hat Donald Trump selbst mit dem Take It Down Act ein Gesetz gegen Deepfakes unterzeichnet. Müsste die US-Regierung es also nicht begrüßen, wenn man auch auf Basis des europäischen DSA gegen sexualisierte Deepfakes vorgeht?

Oliver Marsh: Ich bezweifle, dass die Trump-Regierung diesen Zusammenhang erkennen wird. Egal, was die EU tut, die US-Regierung wird deren Regulierung attackieren, verzerrt darstellen und allein US-Gesetze als brillant bezeichnen. Aber ich hoffe, dass die EU dennoch gezielte und entschiedene Maßnahmen gegen nicht-einvernehmliche sexualisierte Inhalte ergreift und gegen alle Widerstände klar kommuniziert, dass es ihr nicht um Zensur oder Machtpolitik geht.

netzpolitik.org: Wenn Leser*innen euch Hinweise auf bedenkliche Deepfake-Angebote schicken möchten, was sollten sie beachten? Immerhin handelt es sich um potentiell illegale Inhalte.

Oliver Marsh: Menschen sollten illegale Inhalte nicht weiterverbreiten, selbst wenn sie dabei helfen möchten, Belege zu sammeln. Tipps zum Umgang gibt es bei der Internet-Beschwerdestelle, zum Beispiel: keine Inhalte speichern, nicht selbst weiter recherchieren.

Was wir suchen, sind Eckdaten, die uns dabei helfen, unsere textbasierte Suche zu erweitern. Das sind zum Beispiel die Namen von Firmen und Apps oder auch Begriffe, mit denen Menschen verschleiern, wofür ihre Anwendung da ist, zum Beispiel „undress“. Auch der Kontext eines Fundes ist hilfreich, etwa, dass er auf einer bestimmten Plattform beworben wurde.

netzpolitik.org: Vielen Dank für das Interview!

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Der neue Anlauf zur Reform des Bundespolizeigesetzes traf im Innenausschuss des Bundestags auf Kritik. Die Bundespolizei soll künftig Staatstrojaner nutzen dürfen, ohne dass für diese Hacking-Werkzeuge ein IT-Schwachstellenmanagement existiert.

Im Innenausschuss des Bundestags wurde gestern in einer Sachverständigen-Anhörung die Reform des Bundespolizeigesetzes (BPolG) diskutiert. Die Bundesregierung hatte dazu im Dezember einen umfangreichen Gesetzentwurf vorgelegt, der die Befugnisse der Bundespolizei ausbauen soll.

Künftig soll nun auch die Bundespolizei hacken dürfen. Dafür könnten Polizeibeamte Computer oder Smartphones mit Schadsoftware infiltrieren, um laufende Kommunikation und einige weitere Daten auszuleiten.

Neu sind im Gesetzentwurf auch die verdachtsunabhängigen Kontrollen in sogenannten „Waffenverbotszonen“, die von der Ampel-Vorgängerregierung für die Bundespolizei bereits beschlossen worden waren, aber im Bundesrat scheiterten. Diese Kontrollen stehen in der Kritik, weil die Diskriminierung von bestimmten Personengruppen befürchtet wird. Die früher geplanten Kontrollquittungen, die von Polizeibeamten nach solchen Kontrollen ausgehändigt werden sollten, fehlen im Gesetzentwurf.

Weggefallen im Vergleich zum Entwurf der Ampel ist auch die Kennzeichnungspflicht für Polizisten. Uli Grötsch, SPD-Politiker und der Polizeibeauftragte des Bundes beim Deutschen Bundestag, nannte den Streit darum eine „rein ideologische Debatte“. Es gäbe keine schlechten Erfahrungen damit auf Polizeiseite. Er bedauerte die fehlende Kennzeichnungspflicht, die polizeiliches Handeln nachvollziehbarer und transparenter gemacht hätte.

Kritische Anmerkungen von einigen geladenen Sachverständigen betrafen auch die neuen Regelungen zu V-Personen. Das sind polizeiliche Informationszuträger, die aber keine Polizeibeamten sind. Zwar sei der Kernbereichsschutz der Überwachten – also der Schutz ihrer Intimsphäre – im Gesetzentwurf enthalten, damit die V-Personen nicht etwa enge Beziehungen zu Ausgehorchten aufnehmen. Was aber darin fehle, seien zeitliche Vorgaben und ein Katalog, der vorgibt, welche Personen ungeeignet sind. Der war im Vorgängerentwurf der Ampel-Regierung noch enthalten. Er sollte dafür sorgen, dass keine Menschen als V-Personen in Frage kommen, die beispielsweise geschäftsunfähig oder minderjährig sind oder ihr Einkommen wesentlich über Polizeizahlungen beziehen.

Staatstrojaner gegen WhatsApp

Das Bundespolizeigesetz ist ein umfängliches Regelwerk mit zahlreichen Neuerungen. Der Deutsche Anwaltverein (DAV) hatte schon in seiner ersten Stellungnahme zum Referentenentwurf die „äußerst kurze Stellungnahmefrist“ bemängelt, die der umfassenden Reform nicht gerecht werden könne. Der DAV konzentrierte sich daher auf besonders Kritikwürdiges. Dazu gehört die neue Regelung zu einer Version des Staatstrojaners, die im Amtsdeutsch „Quellen-Telekommunikationsüberwachung“ heißt. Diese Form des Staatstrojaners wird durch den Gesetzentwurf erstmals für die Bundespolizei zur Abwehr von Gefahren eingeführt.

Die „Quellen-TKÜ“ lehnt zwar ihren Namen an die Überwachung laufender Telekommunikation an, ist aber praktisch ein Hacking-Werkzeug. Die dafür notwendige Schadsoftware wird unter Ausnutzung von Sicherheitslücken heimlich auf einem Endgerät aufgebracht und zeichnet die gewünschten Inhalte unbemerkt vom Nutzer auf.

Im Gesetzentwurf heißt es, dass die Überwachung und Aufzeichnung von Telekommunikation „ohne Wissen der betroffenen Person auch in der Weise erfolgen [darf], dass mit technischen Mitteln in von der betroffenen Person genutzte informationstechnische Systeme eingegriffen wird“, um an verschlüsselte Gespräche oder Messenger-Nachrichten zu kommen. Die Gesetzesbegründung erwähnt beispielsweise konkret den Messenger WhatsApp, der sich allerdings auch ohne Staatstrojaner als abhörbar erwies.

„Nicht zu Ende gedacht“

Neben der laufenden Telekommunikation sollen mit dem Staatstrojaner auch weitere Kommunikationsinhalte überwacht werden dürfen, „deren Übertragung zum Zeitpunkt der Überwachung bereits abgeschlossen ist“. Praktisch wären das beim Beispiel WhatsApp etwa gespeicherte Chat-Verläufe, die ebenfalls heimlich von der Schadsoftware aufgezeichnet werden dürften. Der Zeitpunkt der Anordnung des Staatstrojaners soll maßgeblich dafür sein, wie weit in die Vergangenheit die Schadsoftware gespeicherte Kommunikationsinhalte überwachen darf.

Die Sachverständige Lea Voigt, Juristin und Vorsitzende des Ausschusses Recht der Inneren Sicherheit im DAV, sieht die Hacking-Befugnisse in ihrer Stellungnahme kritisch. Sie seien auch „nicht zu Ende gedacht“, sagte sie im Ausschuss. Denn laut der Begründung des Gesetzes sind sie für sofortige Interventionen vorgesehen, um Gefahren schnell abzuwehren. Staatstrojaner seien jedoch gar nicht sofort einsetzbar, sondern bräuchten eine gewisse Vorlaufzeit, um die Schadsoftware an Hard- und Software anzupassen, die sie heimlich ausspionieren soll. Die Begründung überzeuge also nicht.

Heiko Teggatz, stellvertretender Bundesvorsitzender der Deutschen Polizeigewerkschaft, wurde in der Anhörung nach einem Beispiel für den Staatstrojanereinsatz gefragt. Er betonte, dass nur die Gefahrenabwehr im Vordergrund stünde, etwa bei Schleusungen. Es „komme nicht selten vor“, dass Polizisten beispielsweise „Handynummern bei geschleusten Personen“ fänden. Keiner wisse, ob es sich dabei um Nummern von Kontaktpersonen, Schleusern oder Angehörigen handele. Dann könne es um die abzuwendende Gefahr gehen, dass an unbekanntem Ort „irgendwo in Europa“ ein LKW führe, in dem Menschen zu ersticken drohten. Ein Staatstrojaner müsse dann „schnell zur Gefahrenabwehr“ genutzt werden.

Es herrscht offenkundig nicht nur bei Teggatz die Vorstellung, dass eine Spionagesoftware ein geeignetes Werkzeug sei, um in kürzester Zeit eine laufende Kommunikation abhören zu können. Denn auch in der Gesetzesbegründung ist der Staatstrojaner als „gefahrenabwehrende Sofortintervention“ charakterisiert.

Die Sachverständige Voigt weist in ihrer Stellungnahme diese Vorstellung ins Reich der Phantasie und zitiert den Generalbundesanwalt. Der hatte aus praktischen Erfahrungen berichtet, dass die Umsetzung der „Quellen-Telekommunikationsüberwachung“ einige Zeit brauche: „In der Regel“ würden „zwischen Anordnung und Umsetzung jedenfalls einige Tage vergehen“.

Staatstrojaner sind Sicherheitsrisiken

Eine „Quellen-TKÜ“ birgt unvermeidlich verschiedene Risiken. Denn ein Staatstrojaner lässt sich nur heimlich einschleusen, wenn IT-Sicherheitslücken bei den gehackten Geräten offenstehen. Und dass sie offengelassen und eben nicht geschlossen werden, ist eine aktive Entscheidung und ein Sicherheitsrisiko für alle Computernutzer.

Zudem hat sich in den letzten Jahren ein wachsender Markt an kommerziellen Staatstrojaner-Anbietern etabliert, der eine zunehmende Bedrohung für die IT-Sicherheit, aber auch für die Achtung der Grund- und Menschenrechte ist. Wird eine Polizeibehörde Kunde eines solchen Anbieters, finanziert sie diesen gefährlichen Markt.

Der Sachverständige Kai Dittmann von der Gesellschaft für Freiheitsrechte (GFF) kritisierte, dass die „Quellen-TKÜ“ der Bundespolizei erlaubt werden soll, obgleich noch immer Vorschriften zum Schwachstellenmanagement fehlen. Denn in Deutschland gibt es bisher keine Regelungen, die IT-Sicherheitslücken hinsichtlich ihrer Risiken bewerten und vorschreiben, wie diese Schwachstellen jeweils zu behandeln sind. Dittmann verwies auf Millionenschäden für die Wirtschaft in Deutschland, die durch offene IT-Sicherheitslücken und Schadsoftware entstünden. Er forderte, ein staatliches Schwachstellenmanagement gesetzlich vorzuschreiben. Die „Quellen-TKÜ“ dürfe erst danach eingeführt werden.

Der Sachverständige erntete damit bei der grünen Innenexpertin und Polizeibeamtin Irene Mihalic Zustimmung. Sie nannt eine Staatstrojanerbefugnis für die Bundespolizei ohne ein vorgeschriebenes Schwachstellenmanagement „unverantwortlich“.

Staatshacker

Wir berichten seit mehr als achtzehn Jahren über Staatstrojaner. Unterstütze uns!

Auch Amnesty International hatte die Staatstrojaner-Befugnis kritisiert und die Besorgnis geäußert, dass die „Quellen-TKÜ“ auch gegen Personen zum Einsatz kommen könnte, die friedliche Proteste planen: Denn der Staatstrojaner „soll bezüglich Straftaten erlaubt werden, die etwa die Störung von öffentlichen Betrieben oder bestimmte Eingriffe in den Straßenverkehr erfassen, und zum Schutz von Einrichtungen des Bahn- und Luftverkehrs – Orten, an denen oft Proteste etwa für mehr Klimaschutz oder gegen Abschiebungen stattfinden“, wie Amnesty International schrieb. In einem Klima zunehmender Repression von friedlichem Protest forderte die Menschenrechtsorganisation „entsprechende Klarstellungen, die einen solchen Missbrauch ausschließen“.

Der Sachverständige Marc Wagner von der Hochschule des Bundes für öffentliche Verwaltung verwies hingegen darauf, dass die „Quellen-TKÜ“ beim Bundeskriminalamt und in einigen Landespolizeigesetzen doch „längst Standard“ wäre. Das sei „nicht anderes als ein Update“. Doch selbst Wagner sieht wie die Sachverständigen Voigt und Dittmann die Eingriffsschwellen für den Staatstrojanereinsatz als zu niedrig.

Dittmann von der GFF bescheinigte dem Gesetzentwurf bei der Staatstrojanerbefugnis zudem „handwerkliche Fehler“. Insgesamt seien die Regelungen bei dieser sehr eingriffsintensiven Maßnahme nicht überzeugend.

Auch gute Nachrichten

Es gibt aus bürgerrechtlicher Sicht auch gute Nachrichten: Sowohl der Ausbau der Gesichtserkennung als auch Regelungen, die eine automatisierte Big-Data-Analyse nach Art von Palantir ermöglichen, sind nicht unter den neuen Befugnissen. Auch findet sich keine „KI“ im ganzen Gesetzentwurf.

Vielleicht ist das auch aus Kostengründen eine gute Nachricht, denn technisierte Überwachung ist ein teures Unterfangen. Der Polizeibeauftragte Grötsch wies in der Anhörung darauf hin, dass Bundespolizisten auch mit lange verschleppten Baumaßnahmen und schlechten Bedingungen an ihren Arbeitsplätzen zu kämpfen hätten, die er „teilweise desolat“ nannte. Die hohen Geldsummen für ohnehin fragwürdige Staatstrojaner-Anbieter könnten vielleicht woanders in der Bundespolizei sinnvoller investiert werden.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Meist im Verborgenen bereiten Unternehmen Daten aus der Online-Werbung für Geheimdienste auf. Manche prahlen damit, praktisch jedes Handy verfolgen zu können. Eine Recherche von Le Monde gewährt seltene Einblicke in eine Branche, die auch europäische Sicherheitsbehörden umwirbt.

Überwachungsfirmen, die auf Daten aus der Online-Werbeindustrie zurückgreifen, umwerben offenbar offensiv europäische Sicherheitsbehörden. Das geht aus einer am 22. Januar veröffentlichten Recherche von Le Monde (€) hervor. Die französische Zeitung konnte mehreren vertraulichen Werbe-Präsentationen unterschiedlicher Hersteller beiwohnen und Gespräche mit französischem Sicherheitspersonal führen.

Die Recherche zeigt, wie aktiv mehrere sogenannte ADINT-Firmen auch in Europa für ihre Dienste werben. Die Abkürzung steht für advertising-based Intelligence, werbebasierte Erkenntnisse. Es geht um einen anscheinend wachsenden Zweig der globalen Überwachungsindustrie, der sich darauf spezialisiert hat, Daten aus dem Ökosystem der Online-Werbung für staatliche Akteure aufzubereiten. Insbesondere für Handy-Standortdaten ist die Online-Werbebranche wohl eine Goldgrube, wie nicht zuletzt unsere Databroker-Files-Recherchen gezeigt haben.

Le Monde gibt nun neue Einblicke in die Selbstvermarktung einer sonst verschlossenen Branche. „Jedes Gerät, jederzeit, überall“, so lautet beispielsweise der Slogan einer ADINT-Firma. „Wir sammeln permanent Daten“, rühmt sich der Vertreter einer anderen. Mindestens eine Person aus französischen Sicherheitsbehörden hat das dem Bericht zufolge beeindruckt.

Von wegen anonym: Daten sammeln, Menschen finden

Für ADINT machen sich Firmen und Behörden zunutze, dass die Online-Werbeindustrie in den vergangenen Jahrzehnten den wohl größten Überwachungsapparat der Menschheitsgeschichte aufgebaut hat. Im Mittelpunkt stehen populäre Handy-Apps. Von dort fließen Standortdaten und andere Informationen in einem unübersichtlichen Ökosystem aus hunderten bis tausenden Firmen, für die Betroffenen weitgehend unkontrolliert. Tracking-Unternehmen, Datenhändler und ADINT-Dienstleister sammeln diese Daten auf unterschiedlichen Wegen ein und gründen darauf ihr Geschäft.

Insgesamt habe LeMonde um die 15 Firmen gezählt, die ADINT-Dienstleistungen anbieten. Darunter mehrere Anbieter mit Sitz in Israel oder den USA wie Penlink, Rayzone, Cognyte und Wave Guard. Doch auch das italienische RCS Lab biete mit seinem Produkt Ubiqo laut Bericht ADINT-Services an. Die genannten Anbieter ließen eine Presseanfrage von netzpolitik.org unbeantwortet.

Eine Vertriebsperson von RCS Lab soll dem Bericht zufolge in einer vertraulichen Präsentation damit geprahlt haben, man könne mit hoher Trefferquote Personen hinter pseudonymen Werbe-IDs identifizieren. Das sind einzigartige Kennungen, die mobile Betriebssysteme von Apple und Google ihren Nutzer*innen verpassen. Apps schicken diese Kennungen ins Werbe-Ökosystem, oftmals gemeinsam mit Standortdaten. Gelegentlich werden solche IDs als „anonym“ bezeichnet.

Laut Le Monde wolle RCS Lab mithilfe von Werbedaten angeblich 95 Prozent der italienischen Handys de-anonymisieren können. Die Zeitung bezieht sich dabei auf Aussagen eines Verkäufers. Auf offizielle Anfrage habe das Unternehmen das gegenüber Le Monde jedoch „vehement“ bestritten.

Durchwachsene Datenqualität

Wie leicht es möglich ist, konkrete Personen mithilfe von Standortdaten aus der Werbe-Industrie zu identifizieren, zeigen die Databroker-Files-Recherchen von netzpolitik.org, dem Bayerischem Rundfunk und Partnermedien. Mit verhältnismäßig einfachen Mitteln und kostenlosen Vorschaudatensätzen ist das mehrfach gelungen. Welcher Aufwand notwendig wäre, um dies im großen Stil zu machen, lässt sich nur schätzen.

Laut Le Monde haben jedoch auch andere Firmen mit ihren Fähigkeiten geworben, Personen gezielt zu identifizieren. Auf der Fachmesse für innere Sicherheit Milipol habe etwa das Unternehmen Wave Guard im Jahr 2025 seine „ADINT-Deanonymisierungsplattform“ vorgestellt. Auch Rayzone und Cognyte hätten demnach ähnliche Fähigkeiten versprochen. Penlink wiederum solle Ermittlern gesagt haben, es nutze gehackte und geleakte Daten aus dem Internet, um Standortdaten und Werbe-IDs echten Personen zuzuordnen.

Im Widerspruch zu vollmundigen Marketing-Versprechen der Branche steht die mangelhafte Qualität der Daten aus der Online-Werbeindustrie. Einer Studie des NATO-Forschungszentrums Stratcom aus 2021 zufolge könnten wohl nur 50 bis 60 Prozent der kursierenden Werbe-Daten als präzise angesehen werden. Die Vertriebsperson eines israelischen Unternehmens habe gegenüber Le Monde geschätzt, dass sogar 80 bis 85 Prozent der Daten, die sie sammeln, unbrauchbar seien.

Realistischerweise könne man weltweit etwa zehn oder 15 Prozent der Handys mit ADINT überwachen, soll eine andere anonyme Quelle geschätzt haben, wie Le Monde berichtet. Für Strafverfolgung eigne sich das weniger, für Geheimdienste jedoch mehr.

Zur Zielgruppe zählt offenbar auch der private Sektor

Beworben werden solche Überwachungsprodukte offenbar auch als Werkzeuge, um Migrant:innen ins Visier zu nehmen. So berichtet Le Monde aus einer vertrauliche Präsentation des Unternehmens Rayzone, das sein ADINT-Produkt als Waffe im „Kampf gegen illegale Migration“ angepriesen haben soll. Durch das gezielte Sammeln von Werbe-IDs an bekannten Grenzübergängen für Geflüchtete sollen Behörden demnach in die Lage versetzt werden, Telefone zu identifizieren, die dort regelmäßig auftauchen. So könnten etwa Schleuser gefunden werden. Gegenüber Le Monde habe Rayzone mitgeteilt, Kund:innen streng zu prüfen. Das Produkt könne nur für bestimmte Zwecke eingesetzt werden, etwa um Kriminalität oder Terror zu verhindern.

Bekannt ist, dass in den USA die paramilitärische ICE-Truppe bereits ADINT-Dienstleister nutzt, um Menschen für die Deportation aufzuspüren. Neu ist hingegen, dass ADINT-Firmen ihre Produkte offenbar nicht nur an staatliche Abnehmer verkaufen. Dem Bericht von Le Monde zufolge soll beispielsweise Wave Guard seine Dienste auch als Werkzeug für Finanzinstitute vermarkten – für „verbesserte Sicherheit und Betrugsprävention“.

Ob auch deutsche Behörden ADINT-Produkte beziehen, ist nicht öffentlich bekannt. Expert:innen halten das für wahrscheinlich, da diese Praxis in anderen europäischen Ländern wie Norwegen und den Niederlanden bereits belegt ist. Erst im Dezember verweigerte die Bundesregierung jedoch der Bundestagsabgeordneten Donata Vogtschmidt (Die Linke) eine Antwort auf diese Frage.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Nach einer Flut sexualisierter Grok-Deepfakes auf X prüft nun die EU-Kommission, ob Elon Musks Unternehmen gegen den Digital Services Act verstoßen haben. Erste Studien liefern derweil Details über das Ausmaß der produzierten sexualisierten Bilder.

Am Montagmittag hat die EU-Kommission ein weiteres Verfahren gegen den Kurznachrichtendienst X eingeleitet. Dabei will sie prüfen, ob das eng mit dem KI-Chatbot Grok verzahnte soziale Netzwerk gegen den Digital Services Act (DSA) verstoßen hat. Der Kommission zufolge ist unklar, ob der Online-Dienst vor dem Ausrollen des Produkts damit verbundene Risiken untersucht hat.

Elon Musks Plattform X ist mit dem integrierten KI-Chatbot zuletzt stark in die Kritik geraten, nachdem dieser auf Nachfrage von Nutzer*innen ungefiltert sexualisierte Bilder von Frauen und Kindern auf X veröffentlicht hat.

Nachdem X lange untätig blieb, hatte das Unternehmen am 9. Januar angekündigt, die Funktion zahlenden Nutzer*innen vorzubehalten. Am 14. Januar kündigte X dann weitere technische Maßnahmen an und schränkte die pornografische Bildgenerierungsfunktion nach eigenen Angaben für alle Nutzer*innen ein. Für andere Zwecke soll das Bildfeature jetzt nur noch zahlenden X-Nutzer*innen offenstehen.

Erst am vergangenen Dienstag hatte das EU-Parlament über KI-Deepfakes in sozialen Medien debattiert. Kurz danach haben mehr als fünfzig Abgeordnete in einem Brief die EU-Kommission zu konsequenterem Vorgehen im Falle Grok aufgefordert.

X muss Nachweise liefern

Nun muss die Plattform vor der EU-Kommission Rechenschaft ablegen, ob es der gesetzlich vorgeschriebenen Risikobewertung und -minderung nachgekommen ist. Solche Berichte sollen potenzielle „systemische Risiken“ aufdecken, die von Online-Diensten ausgehen können. Sollte X vor der Integration von Grok keine Folgenabschätzung vorgenommen haben, könnten auf X hohe Geldbußen zukommen.

Dass der Schaden bereits eingetreten ist, führte EU-Digitalkommissarin Henna Virkkunen aus: „Sexualisierte Deepfakes von Frauen und Kindern sind eine gewalttätige, inakzeptable Form der Entwürdigung. Mit dieser Untersuchung werden wir feststellen, ob X seinen gesetzlichen Verpflichtungen gemäß dem DSA nachgekommen ist oder ob es die Rechte europäischer Bürger – einschließlich der Rechte von Frauen und Kindern – als Kollateralschaden seines Dienstes behandelt hat.“

Die Einleitung solch eines Verfahrens ist noch kein Nachweis für einen Verstoß gegen den DSA. Allerdings befähigt es die Kommission zu weiteren Maßnahmen. Sie kann beispielsweise Unterlagen betroffener Unternehmen anfordern, Durchsuchungen vornehmen oder Mitarbeiter*innen befragen.

Neben dem neuen Verfahren hat die EU-Kommission angekündigt, eine seit Dezember 2023 laufende Untersuchung zu verlängern, die sich unter anderem auf die Moderationsfunktion, Maßnahmen gegen illegale Inhalte und Risiken des Empfehlungssystems bezieht. Das Verfahren umfasst zusätzlich die mangelnde Werbetransparenz von X. Dafür verhängte die EU-Kommission Anfang Dezember eine 120-Millionen-Euro-Geldbuße, da die Plattform Vorschriften nicht eingehalten hatte.

Sexualisierte Deepfakes im Millionenfachen

Inzwischen haben mehrere Organisationen die Tragweite der Vorfälle untersucht. Die britische NGO Center for Countering Digital Hate (CCDH) schätzt etwa, dass im Zeitraum vom 29. Dezember bis 8. Januar über 4 Millionen Bilder generiert wurden. Davon sollen rund 3 Millionen sexualisierter Art gewesen sein, auf rund 23.000 Bildern sollen Kinder dargestellt worden sein.

Die NGO AI Forensics kommt zu ähnlichen Ergebnissen. Bis zum 1. Januar waren mehr als die Hälfte der generierten Bilder sexualisierte Deepfakes. Nachdem X am 14. Januar technische Einschränkungen vorgenommen hatte, sei der Anteil sexualisierter Bilder auf unter 10 Prozent gefallen.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Kinder und Jugendliche haben ein Recht auf Information und Teilhabe – auch auf sozialen Medien. Wenn Erwachsene sie per Social-Media-Verbot von solchen Orten der Meinungsbildung ausschließen, werden sie ihrer Verpflichtung nicht gerecht.

Wer Kinder und Jugendliche von sozialen Medien ausschließen möchte, um sie zu schützen, der könnte ihnen ebenso die Teilnahme an Demonstrationen verbieten. Schließlich könnte man sich dabei verletzen, manchmal werden Steine geschmissen und viele Demo-Parolen sind sehr polemisch. Auch die Mitgliedschaft in einer Partei könnte eine Altersgrenze bekommen; der Politikbetrieb ist alles andere als harmlos. Und bei all den Horrornachrichten wäre es besser, wenn junge Menschen nicht länger die Tagesschau sehen dürften.

Solche Forderung stellt derzeit zwar keiner. Sie machen aber deutlich, was hinter dem vielfach geforderten Social-Media-Verbot steckt: Im Namen des Schutzes für Minderjährige wird mehr eingeschränkt, als nötig wäre. Das Recht junger Menschen auf politische Teilhabe und die Pflicht des Staats, sie dazu zu befähigen, fallen unter den Tisch.

Seit die australische Regierung Ende des vergangenen Jahres ein Social-Media-Verbot für Menschen unter 16 Jahren eingeführt hat, findet die Regelung auch in Deutschland immer mehr Zuspruch. Hierzulande drehen sich große Teile der Debatte darum, ob ein Verbot für bestimmte Altersgruppen juristisch umsetzbar wäre, welche technischen Mittel wie datensicher wären und wie hoch die Altersgrenze sein sollte. Doch egal, welche Methode zur Durchsetzung eines Social Media-Verbots für Kinder und Jugendliche herangezogen würde: Der Ausschluss einer ganzen Bevölkerungsgruppe von relevanten Orten der politischen Teilhabe ist nicht mit ihren Teilhaberechten vereinbar.

Es darf nicht nur Hürden geben

Besonders düster sind die Bilder, die Befürworter eines Social-Media-Verbots für Jugendliche malen. Soziale Medien würden junge Menschen demnach regelrecht vergiften. Es drängt sich der Eindruck auf, Reels zu schauen sei ungefähr genauso schädlich, wie Crack zu nehmen, und gehöre selbstredend verboten.

Oft ins Feld geführt wird außerdem, Jugendliche seien besonders empfänglich für politischen Populismus in sozialen Medien, der eine der Hauptursachen für die Zunahme radikal rechter Tendenzen bei jungen Menschen wäre. Um das zu verhindern, solle man deswegen für antidemokratische Inhalte empfängliche Menschen von bestimmten Plattformen ausschließen.

Oft vernachlässigt wird in der Debatte jedoch, dass Kinder und Jugendliche nicht nur das Recht haben, vor jugendgefährdenden Inhalten geschützt zu werden. Kinder und Jugendliche haben all die Grundrechte, die auch Erwachsene haben. Nicht ihre Freiheit muss begründet werden, sondern die Begrenzung ihrer Freiheitsrechte.

Für Kinder und Jugendliche bedeutet das: Es darf nicht nur Hürden geben, sondern es muss auch Freiheiten geben – etwa die, sich zunehmend selbstständig aus einer Vielzahl öffentlicher Quellen zu informieren, Medien selbst zu wählen und Informationen mit anderen zu teilen. Eine Beschränkung dieser Freiheit wäre ein starker Eingriff in die Grundrechte einer Bevölkerungsgruppe, die über zwölf Millionen Menschen umfasst.

Instagram ist kein Psychothriller

Auch für Filme, Spiele und Bücher gibt es Altersgrenzen – aber soziale Medien sind kein einzelnes Medium wie ein Film, sondern große, vielfältige Räume des öffentlichen Lebens. Sie sind der Ort, an dem Kinder und Jugendliche in großer Zahl etwa Nachrichten konsumieren, politische Geschehnisse verfolgen und sich eine Meinung bilden.

Junge Menschen informieren sich zunehmend weniger über klassische Nachrichtenmedien wie den Rundfunk oder Tageszeitungen. Dass 12- bis 15-Jährige nach einem Social-Media-Verbot verstärkt damit anfangen würden, die FAZ zu lesen oder das Heute Journal zu schauen, ist lebensfremd. Was ein solches Verbot also bewirken würde, ist, Jugendliche von Information auszuschließen und ihre Informiertheit zu verringern.

Das Recht, sich ungehindert zu informieren und eine eigene Meinung zu bilden, unterscheidet sich in seiner Relevanz für die Gestaltung des eigenen Lebensentwurfs junger Menschen fundamental von der grundsätzlichen Freiheit, einen Psychothriller zu schauen oder einen Ego-Shooter zu spielen.

Wer Kinder und Jugendliche vor den schädlichen Aspekten sozialer Medien schützen möchte, müsste also spezifischer vorgehen, je nach konkretem Risiko. Um Jugendliche vor Horrorfilmen zu schützen, gibt es schließlich auch kein pauschales Kinoverbot, sondern eine Altersgrenze pro Film. Entsprechend bräuchte es zum Beispiel eher Einschränkungen für die potenziell radikalisierende Sogwirkung algorithmisch sortierter Feeds auf sozialen Medien – aber kein pauschales Social-Media-Verbot.

Auf sozialen Medien geht es um Austausch

Was soziale Medien ebenso fundamental von Büchern oder Filmen unterscheidet, ist, dass sie nicht nur konsumiert werden, sondern auch Plattform für Austausch sind. Menschen teilen eigene Informationen über soziale Medien, etwa explizit politische Meinungen oder bloße Dokumentationen ihres Alltags, und geben sie an andere weiter, die diese Inhalte wiederum selbst konsumieren und weitergeben können. Dazu gehört auch etwa das Liken und Kommentieren von Beiträgen.

Das bedeutet, dass soziale Medien nicht nur Räume sind, an denen Informationen und Meinungen passiv wahrgenommen werden – etwa, wenn man sich die Tagesschau ansieht –, sondern auch aktiv geteilt und verbreitet werden – wie wenn man ein Flugblatt verteilt oder eine Demo-Rede hält.

Politische Teilhaben stärken statt schwächen

Erwachsene sollten Möglichkeiten zur politischen Teilhabe von Kindern und Jugendlichen stärken, statt sie durch ein Social-Media-Verbot zu schwächen. Minderjährige von sozialen Medien auszuschließen würde Misstrauen in eine gesamte Generation ausdrücken und könnte den Eindruck erwecken, man würde sich vor der Politisierung junger Menschen fürchten.

Vielmehr müssen junge Menschen stärker in die öffentliche Meinungsbildung mit einbezogen werden. Soziale Medien sind dazu besonders gut geeignet, weil Jugendliche sich dort austauschen, vernetzen und organisieren können. Bewegungen wie etwa Fridays for Future, #MeToo, Black Lives Matter, „Frau, Leben, Freiheit“ oder die Proteste um Lützerath hätten wohl nicht dieselbe Resonanz gefunden, wenn insbesondere junge Menschen nicht über etwa Instagram oder Twitter davon erfahren und daran teilgenommen hätten. Wäre der Demokratisierung junger Menschen geholfen, sie von diesen Teilhabemöglichkeiten auszuschließen?

Würde jetzt ein Social-Media-Verbot für Kinder und Jugendliche eingeführt werden, würden bestehende demokratiekritische Tendenzen bei jungen Menschen nicht einfach verschwinden. Wahrscheinlicher ist, dass viele junge Menschen das Verbot als Beeinträchtigung ihrer Informations- und Meinungsfreiheit erkennen und darüber – auch politisch – frustriert wären.

BzKJ sieht Verstoß gegen UN-Kinderrechtskonvention

Ablehnung für das Social-Media-Verbot gibt es nicht nur von Kindern und Jugendlichen, die sich ihre digitalen Räume nicht wegnehmen lassen möchten. Die Bundeszentrale für Kinder- und Jugendmedienschutz sieht in einem Social-Media-Verbot für unter 16-Jährige gar einen Verstoß gegen den 17. Artikel der UN-Kinderrechtskonvention. Demnach müssen die Vertragsstaaten sicherstellen, dass Kinder „Zugang [haben] zu Informationen und Material aus einer Vielfalt nationaler und internationaler Quellen“.

Das Internet und die Plattformen, die es bereithält, gehören zur Lebenswelt von Kindern und Jugendlichen und sind ein wesentlicher Ort, an dem sie Informationen erlangen. Gerade deshalb muss ihnen ein sicherer Zugang dazu ermöglicht werden. Um das zu erreichen, sieht das EU-Gesetz über digitale Dienste (DSA) je nach Dienst und Risiko zahlreiche mögliche Maßnahmen vor: Neben Datenschutz-wahrender Altersverifikation sind das etwa ein Verbot suchtförderder Funktionen oder verstärkte Anforderungen an Inhaltsmoderation.

Plattformen für alle sicherer machen

Es stimmt, dass soziale Medien diverse Gefahren bereithalten. Sexuelle Übergriffe, Bedrohungen, Desinformation, manipulative Designs, Gewaltdarstellungen oder demokratiefeindliche Inhalte sind nur einige davon. Das sind jedoch nicht nur Gefahren für Kinder und Jugendliche, sondern für alle. Besonders angreifbar sind dabei vulnerable Gruppen – nicht alle haben die hohe Medienkompetenz oder die ausgefeilten Recherche-Kenntnisse, die dabei helfen, sich vor Übergriffen zu schützen.

Es gibt auf sozialen Medien auch Inhalte, die niemand sehen sollte, weder Kinder noch Erwachsene. Etwa weil sie in extremem Maße gewaltverherrlichend, volksverhetzend oder ehrverletzend sind. Vor der Verbreitung solcher Inhalten müssen mehr Menschen als nur Kinder und Jugendliche geschützt werden – sowohl diejenigen, die als Opfer in diesen Darstellungen abgebildet werden als auch die Vielzahl von Menschen, die durch den Konsum solchen Materials gefährdet werden kann. Gegenüber all diesen Menschen hat der Staat eine Schutzpflicht.

Wenn der Staat sich hier aber nicht imstande sieht, seinen Schutzpflichten gegenüber der gesamten Bevölkerung gerecht zu werden, entscheidet er sich stattdessen für einen unverhältnismäßigen Eingriff in die Rechte einer Bevölkerungsgruppe.

Statt Kinder und Jugendliche von potenziell gefährlichen Orten auszuschließen, sollten die Gefahren selbst entschärft werden. Das muss insbesondere durch konsequente Plattformregulierung und eine politische Weiterentwicklung des DSA geschehen. Das Ziel sollte sein, Plattformen für alle Menschen sicherer zu machen.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Die 4. Kalenderwoche geht zu Ende. Wir haben 10 neue Texte mit insgesamt 72.575 Zeichen veröffentlicht. Willkommen zum netzpolitischen Wochenrückblick.

Liebe Leser*innen,

der TikTok-Deal ist komplett. Das US-Geschäft der einflussreichen Plattform liegt nun in den Händen des Konsortiums „TikTok USDS“ und rückt damit stärker unter den Einfluss der rechtsradikalen Trump-Regierung.

Große Anteile haben die US-Investmentfirma Silver Lake und der Cloud-Anbieter Oracle. Letzterer wurde gegründet von Trump-Amigo Larry Ellison. Ein weiterer großer Anteil liegt bei einem Staatskonzern der Vereinigten Arabischen Emirate, einer Monarchie. Das chinesische ByteDance behält knapp ein Fünftel der Anteile.

Wenn das vor sechs Jahren geschehen wäre, als die zähe TikTok-Saga ihren Anfang nahm, hätte mich das aufgewühlt. Damals hatte ich nämlich noch TikTok aktiv genutzt. Es hätte mich persönlich umgetrieben, was all das nun genau bedeutet:

- Wohin fließen meine Daten, wenn ich direkt mit US-Inhalten interagiere?

- Bekommt die Moderation der Inhalte von US-Creator*innen einen MAGA-Drall?

- Werden Menschen in den USA jetzt mehr rechtsradikale Propaganda in ihren Feeds sehen?

Auf diese Fragen habe ich heute keine Antwort. Was wir wissen: Mehr US-Einfluss macht die Plattform nicht vertrauenswürdiger als vorher. Schon vorher war es schwer zu durchschauen, was wirklich bei TikTok vor sich geht. Künftig wird es noch schwieriger.

Immer wieder hatte TikTok in der Vergangenheit etwa den Einfluss des chinesischen Mutterkonzerns ByteDance heruntergespielt – und damit auch die Nähe zur chinesischen Regierung. Bis heute ist unklar, in welchem Umfang Daten von EU-Nutzer*innen nach China geflossen sind. Nun hat sich mit den USA ein weiterer fragwürdiger Player im Maschinenraum der Plattform breit gemacht.

Tor für Popkultur und Information

Zwar hat TikTok für meinen eigenen Medienkonsum inzwischen keine Bedeutung mehr. Trotzdem weiß ich, dass TikTok für viele Menschen das Tor schlechthin ist zu Popkultur, Information und Unterhaltung. TikTok hat also kulturellen und politischen Einfluss. Nach dem TikTok-Deal muss sich die Plattform die Frage gefallen lassen: Wie stark wird MAGA künftig auf TikTok Einfluss nehmen?

Klare Antworten könnten lange auf sich warten lassen. Mögliche Einflussnahmen auf große Social-Media-Plattformen können nämlich auch sehr subtil sein, und dennoch eine breite Wirkung haben:

- Mit welchen konkreten Signalen arbeiten die Filtersysteme der Inhaltsmoderation?

- Mit welcher Priorität prüfen wie viele Menschen welche Inhalte?

- Sollen die Empfehlungsalgorithmen eher Inhalte bevorzugen, die Menschen beruhigen und ablenken – oder eher Inhalte, die sie aufwühlen und aktivieren?

Diese Beispiele zeigen: Schon mit simplen Stellschrauben einer großen Plattform lässt sich das allgemeine Befinden oder die Aufmerksamkeit eines US-amerikanischen Millionenpublikums in bestimmte Richtungen lenken. Und selbst wenn solche Einflussnahmen nicht bewusst geschehen, sondern Nebeneffekte einer Plattform sind, die bloß ihren Profit maximieren will – unbedenklich werden sie dadurch nicht.

Um die Medienmacht großer Plattformen wie TikTok untersuchen zu können, um den Verdacht von Einflussnahme auszuräumen, dafür bräuchte es Transparenz. Etwa durch einen wirksamen Zugriff auf interne Daten für unabhängige Forschende. In der EU gibt es Gesetze dafür, TikTok und andere große Plattformen sträuben sich dennoch dagegen. Diese Intransparenz hinterlässt bei mir ein mulmiges Gefühl.

Euch ein schönes Wochenende

Sebastian

US-Einwanderungsbehörde: Mit Palantir und Paragon auf Migrantenjagd

Die US-Einwanderungsbehörde ICE nutzt für ihre Massenfestnahmen zunehmend digitale Überwachungstechnologie. Ein berüchtigter Konzern liefert dafür das „ImmigrationOS“. Doch es gibt Ideen für eine Kampagne, die sich gegen diese Beihilfe zur Menschenjagd richtet. Von Matthias Monroy –

Artikel lesen

Generative KI: Finger weg von Bildgeneratoren

Nicht alle KI-Bilder sind KI-Slop, findet unser Autor. Trotzdem rät er Redaktionen von Bildgeneratoren ab. Zu den Gründen gehören hohe unsichtbare Kosten und die gefährliche Machtkonzentration der Tech-Konzerne. Ein Essay. Von Sebastian Meineck –

Artikel lesen

Konsultation: EU-Kommission arbeitet an neuer Open-Source-Strategie

Die EU-Kommission erkennt Open Source als entscheidend für die digitale Souveränität an und wünscht sich mehr Kommerzialisierung. Bis April will Brüssel eine neue Strategie veröffentlichen. In einer laufenden Konsultation bekräftigen Stimmen aus ganz Europa, welche Vorteile sie in offenem Quellcode sehen. Von Anna Ströbele Romero –

Artikel lesen

Partnerschaftsgewalt: „Viel zu wenige wissen, dass es solche Tools gibt“

Die Juristin Franziska Görlitz erklärt, wie man die Hersteller von Spionage-Programmen zur Rechenschaft ziehen kann – und warum wir viel öfter überprüfen sollten, welche Apps auf unseren Telefonen laufen. Von Chris Köver, Martin Schwarzbeck –

Artikel lesen

Bundesdruckerei: Datenatlas Bund ist durchgefallen

Noch im Dezember hat die Bundesdruckerei den Datenatlas Bund mit allen Mitteln vor öffentlicher Kritik abgeschirmt. Nun ist das Großprojekt für die datengetriebene Verwaltung gescheitert. Das Finanzministerium hat es abgehakt, das Digitalministerium weist es zurück. Von Esther Menhard –

Artikel lesen

Digital Networks Act: So will die EU-Kommission den Sprung ins Glasfaserzeitalter schaffen

Mit dem lange erwarteten Digital Networks Act (DNA) zeigt die EU-Kommission, wie sie sich den EU-Markt für Telekommunikation vorstellt. Die Vision eines umfassend harmonisierten Binnenmarktes will sie vorerst nicht umsetzen, geht jedoch erste Schritte in diese Richtung. Von Tomas Rudl –

Artikel lesen

Firmenübernahme: US-TikTok rückt zu Trump

Jetzt wurde die Firma gegründet, die den US-Zweig von TikTok vor dem Verbot rettet. Ein internationales Konsortium übernimmt 80 Prozent, die Daten liegen künftig bei einem Trump-Kumpel. Von Martin Schwarzbeck –

Artikel lesen

Gefährliche Abhängigkeiten: EU-Parlament macht Vorschläge für mehr digitale Souveränität

Die Abgeordneten des EU-Parlaments sehen eine Gefahr in der technologischen Abhängigkeit der EU. In einem Bericht präsentieren sie mögliche Lösungswege. Jetzt sind die Kommission und die EU-Länder an der Reihe, die Forderungen umzusetzen. Von Anna Ströbele Romero –

Artikel lesen

Bayerischer Landtag: Streit um Microsoft eskaliert

Das bayerische Finanzministerium will weiterhin Microsoft-Produkte im Freistaat einsetzen und dafür einen millionenschweren Vertrag verlängern. Die Opposition will eine Abkehr vom Tech-Riesen und fordert „digitale Souveränität“. Doch auch diese Forderung könnte sich als Bumerang erweisen. Von Esther Menhard –

Artikel lesen

Gaming-Plattform Roblox: Gewalt und bauchfreie Oberteile

Berichte über zahlreiche Fälle von Cybergrooming auf der Gaming-Plattform Roblox werfen Fragen über ihre Sicherheit auf. Ich erkunde Roblox, um mehr über die Probleme herauszufinden, und begegne sinnloser Gewalt und knappen Outfits für Fünfjährige. Von Paula Clamor –

Artikel lesen

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Berichte über zahlreiche Fälle von Cybergrooming auf der Gaming-Plattform Roblox werfen Fragen über ihre Sicherheit auf. Ich erkunde Roblox, um mehr über die Probleme herauszufinden, und begegne sinnloser Gewalt und knappen Outfits für Fünfjährige.

Wir stehen umschlungen in der Ecke eines verlassenen Klassenzimmers. Meine Arme liegen um den Hals meines unbekannten Gegenübers, während er mich so an der Hüfte hält, dass meine Füße über dem Boden schweben. Ich trage eine winzige Shorts und ein bauchfreies Oberteil, das ist hier für Frauen der Standard. Er trägt lange Hose und T-Shirt. Ich wollte diese Umarmung nicht. Er hat mich einfach gepackt. Ich versuche mehrfach, mich aus seinem Griff zu befreien, er fragt nach meinem Namen.

Der Übergriff geschieht in einem Computerspiel namens „Boys and Girls Highschool experience roleplay“. Auf der populären Gaming-Plattform Roblox werden Millionen Spiele angeboten, Nutzer*innen können dort auch selbst Spiele erstellen. Roblox ist eines der populärsten Videospielangebote der Welt. Über zwei Stunden verbringen Kinder dort im Schnitt am Tag, so eine Studie. Doch Roblox ist in Verruf geraten.

Im vergangenen Jahr reichten mehrere Bundesstaaten der USA Klagen gegen den Gaming-Giganten ein. Sie werfen der Roblox Corporation vor, minderjährige Nutzer*innen nicht ausreichend vor Sexualstraftäter*innen zu schützen. Liz Murrill, Generalstaatsanwältin von Louisiana, schrieb: „Roblox wird von schädlichen Inhalten und Sexualstraftätern überrannt, da die Plattform Nutzerwachstum, Umsatz und Profit über die Sicherheit von Kindern stellt.“

Altersempfehlung: ab 16. Freigabe: ab 5.

Roblox dürfen Nutzer*innen ab fünf Jahren spielen. Die Altersempfehlung der deutschen Unterhaltungssoftware Selbstkontrolle (USK) allerdings wurde im vergangenen Jahr von 12 auf 16 Jahre erhöht, unter anderem weil Kinder auf der Plattform vielen Kaufanreizen ausgesetzt seien. Mit der Währung „Robux“, die man auf der Plattform oder Tauschbörsen für echtes Geld erwerben kann, können sich Spieler*innen Waffen und andere Spielvorteile kaufen sowie ihren Avatar individualisieren.

Einige Monate nachdem die USK ihre Altersempfehlung für Roblox heraufgesetzt hatte, gab die Spieleplattform eine Kooperation mit der International Age Rating Coalition bekannt, deren Mitglied die USK ist. Die einzelnen Spiele sollen künftig regional unterschiedlich altersklassifiziert werden, auf Basis eines Fragebogens, den die Spiel-Entwickler*innen ausfüllen. Diese Einstufungen werden von der International Age Rating Coalition und ihren Mitgliedsorganisationen überwacht.

Roblox unterteilt Spiele in vier Kategorien: minimal, mild, moderat und beschränkt. Erlebnisse der Kategorien minimal und mild sind allen Spieler*innen zugänglich. Erst wenn Spiele „moderate Gewalt, leichtes realistisches Blut, milderen derben Humor und milde wiederholte Angst“ enthalten, stuft Roblox diese als moderat ein und verbirgt sie vor Kindern unter neun Jahren. Alle Inhalte mit dem Label „beschränkt“ sind erst ab 18 Jahren einsehbar.

Ich will wissen, was Roblox den Kindern zumutet, die dort Spiele spielen, und erstelle deshalb einen Account. Dabei gebe ich an, acht Jahre alt zu sein. Dennoch empfiehlt mir Roblox auf der Startseite Spiele aus dem „Horror“-Genre. In „Käse-Flucht (Horror)“ werde ich von einer monströsen Ratte durch ein Labyrinth aus Käse verfolgt. In „SCP-Monster“ begegnet mir zu Gruselsounds ein oberkörperfreier Machetenträger. Beide Spiele dürfen auch Fünfjährige schon spielen.

Sturmgewehr, Messer oder Handgranate?

„Kampfarena“ ist ein weiterer Vorschlag auf meiner Startseite. Auch dieses Spiel ist laut der Kennzeichnung für Fünfjährige geeignet. Hier muss man andere Spieler*innen mit einem Sturmgewehr erschießen oder mit Messern und Handgranaten töten. „nice, headshot“ schreibt eine*r der Mitspieler*innen im Chat.

Im Spiel „Dress To Impress“ geht es darum, sich zu einem vorgegebenen Thema möglichst attraktiv zu kleiden, um gute Bewertungen der Mitspieler*innen zu bekommen. Weibliche Avatare haben dabei eine Figur, die Barbie im Vergleich dick aussehen lassen würde.

Bei „[FREE] Hug Fights“ haben weibliche Charaktere, wie auch bei „Highschool experience“ fast nur extrem knappe Outfits zur Auswahl. Die meisten bestehen aus einer winzigen Shorts mit bauchfreiem Oberteil.

Als ich das Spiel starte, werde ich von einem Fremden in ein leeres Haus getragen. Dann kommt ein anderer Avatar und nimmt mich dem ersten ab. Er lässt mich fallen und wirft eine Bombe auf mich – Game Over. Während ich abtrete, sehe ich noch, wie meine ehemaligen Träger sich mit anderen Spielenden schlagen.

Grooming über die Chatfunktion

Auch in „Brookhaven RP“ stirbt mein Avatar schnell. „Brookhaven RP“ ist eine Art sozialistisches Paradies, in dem Häuser, Transport- und Lebensmittel für alle frei verfügbar sind. Um meine Nachbarn kennenzulernen, mache ich einen Ausflug zu einem Haus in meiner Nähe. Ich klingele, zwei Avatare kommen heraus und springen um mich herum. Mein Avatar zerfällt. Meine Nachbarn haben mich umgebracht.

Ich erlebe viel Gewalt in Roblox-Spielen und auch eine unangemessene Sexualisierung weiblicher Körper. Grooming-Versuche habe ich allerdings nicht erlebt. Die geschehen angeblich vor allem über die Chatfunktion.

Da mein Account vorgibt, acht Jahre alt zu sein, sind für mich nur die Chats der einzelnen Spiele zugänglich. Am Chat von „Brookhaven RP“ kann ich teilnehmen, auch ohne die Zustimmung eines Eltern-Accounts. Einen solchen kann man aus Sicherheitsgründen mit den Accounts Minderjähriger verknüpfen.

Im Chat wird jemand als „Hässlichkeit“ beleidigt, ein Mensch schreibt „DIGGA KÜSS MICH ND“, ein anderer verkündet: „Ich steche Männer ab“.

Aufgemalte Bartstoppeln sollen die Altersschätzung täuschen

Wer mit anderen Nutzer*innen auch außerhalb einzelner Spiele – und womöglich auch unter vier Augen – chatten möchte, muss sich seit Anfang Januar einem Gesichtsscan unterziehen, mit dem das Alter bestimmt werden soll. Spieler*innen sollen so in Altersklassen, wie 13-16 und 18+, einsortiert werden und nur mit Menschen aus eigenen oder angrenzenden Altersstufen chatten können.

Berichten zufolge funktioniert der Gesichtsscan nicht einwandfrei. Es gebe Nutzer*innen, deren Alter als zu gering eingeschätzt wird. Andererseits behaupten Kinder, die Software mit aufgemalten Bartstoppeln und Falten zu einer höheren Alterseinschätzung gebracht zu haben.

Zum Teil bahnten Täter*innen Gespräche mit Minderjährigen auf Roblox an, um sie dann auf anderen Plattformen weiterzuführen, zum Beispiel auf Discord. Die US-amerikanische Kanzlei Anapol Weiss vertritt Opfer, die über Roblox sexuell ausgebeutet wurden, und hat in zehn Fällen Klage gegen Roblox eingereicht, in sechs dieser Fälle haben die Täter*innen ihre Kommunikation mit den Opfern von Roblox zu Discord verlegt. Die Kanzlei gibt außerdem an, hunderte ähnliche Fälle zu bearbeiten.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Das bayerische Finanzministerium will weiterhin Microsoft-Produkte im Freistaat einsetzen und dafür einen millionenschweren Vertrag verlängern. Die Opposition will eine Abkehr vom Tech-Riesen und fordert „digitale Souveränität“. Doch auch diese Forderung könnte sich als Bumerang erweisen.

Die öffentliche Verwaltung steckt in einem Dilemma: Seit Jahrzehnten nutzen die meisten Behörden Microsoft-Produkte und Alternativen sind offenbar nur schwer vorstellbar. Nirgends zeigt sich das derzeit so deutlich wie in Bayern.

Im Oktober regte sich Kritik (PDF) an den Plänen des bayerischen Finanzministers Albert Füracker (CSU), Microsoft für fünf weitere Jahre in der Landesverwaltung einsetzen zu wollen. Seit 2023 besteht ein sogenannter Handelspartnervertrag zwischen der bayerischen Staatsverwaltung und dem US-Konzern. Er legt die Konditionen fest, zu denen das Bundesland Bürosoftware und Windows-Lizenzen bezieht. Dieses Vertragsverhältnis will Füracker nun verlängern.

Doch es regt sich breiter Widerstand gegen seine Pläne. „Wir reden hier nicht über den Kauf einzelner Excel-Lizenzen, sondern über eine Zementierung unserer kompletten digitalen Infrastruktur auf Jahre hinaus“, sagt Florian von Brunn (SPD) gegenüber netzpolitik.org.

Aber auch in der Landesregierung gibt es deutliche Kritik. Füracker und Digitalminister Fabian Mehring (Freie Wähler) stritten öffentlich um Datenschutz, Abhängigkeit – und um die Frage, ob die US-Regierung über Microsoft auf bayerische Daten zugreifen könnte. Die breite Medienberichterstattung über den Konflikt brachte Markus Söder (CSU) dazu, sich einzuschalten: „Solche Fragen gehören intern besprochen“, mahnte der bayerische Ministerpräsident.

Mit alten Gewohnheiten brechen

Dass die öffentliche Verwaltung auch ohne Microsoft-Produkte arbeiten kann, zeigt das Beispiel Schleswig-Holstein. Das nördliche Bundesland gelang vergangenes Jahr der Umstieg auf einen Open-Source-Arbeitsplatz in der öffentlichen Verwaltung. Das Fazit fällt bisher positiv aus. Seit dem Umstieg habe man bereits rund 15 Millionen Euro an Lizenzkosten eingespart, sagt Digitalisierungsminister Dirk Schrödter auf Anfrage. Dagegen befürchten Fürackers Kritiker, dass der für seine Verhandlungen mit Microsoft einen dreistelligen Millionenbetrag veranschlagt. Auf Anfrage von netzpolitik.org will sich das Ministerium weder zu den Lizenzkosten noch dazu äußern, mit welchen Einsparungen es rechnet.

Auch in Bayern schaut man Richtung Norden. Er stehe im engen Austausch mit der SPD-Fraktion in Kiel, erklärt von Brunn. Er hofft offenbar darauf, dass die positiven Impulse von dort auch im Süden ankommen. „Es entbehrt nicht einer gewissen Ironie, dass die Regierung Söder in Bayern die Zeichen der Zeit nicht erkennt, während der CDU-Kollege Daniel Günther im Norden auf digitale Souveränität setzt.“

Als „Zeichen der Zeit“ sehen derzeit viele die dramatische geopolitische Lage, ausgelöst durch eine erratische Politik der US-Administration unter Präsident Donald Trump.

Trumps langer Arm

Die Auswirkungen zeigt etwa der Fall am Internationalen Strafgerichtshof in Den Haag. Mindestens zwei Richter verloren im Mai vergangenen Jahres jeglichen Zugriff auf digitale Dienste von US-amerikanischen Unternehmen, mutmaßlich infolge ihrer Rechtsprechung. Zu diesen Diensten gehören auch Microsoft-Produkte wie Outlook oder Office.

Seitdem stellen sich Politiker*innen zunehmend die Frage, wie viel Microsoft in der öffentlichen Verwaltung vertretbar ist – zumal diese in der Regel auch mit sensiblen Daten arbeitet. Zwar versichert das bayerische Finanzministerium gegenüber netzpolitik.org, dass die Daten dauerhaft „in mehreren staatseigenen Rechenzentren auf bayerischem Boden gesichert“ seien. Das schließt aber nicht aus, dass US-Behörden auch auf bayerische Verwaltungs- und Bürger:innendaten zugreifen.

Zu diesem Schluss kommt ein Gutachten vom März 2025, das im Auftrag des Bundesinnenministeriums (BMI) erstellt wurde. Demnach erlaube der US-amerikanische Clarifying Lawful Overseas Use of Data Act, kurz CLOUD Act, den dortigen Sicherheitsbehörden weitreichenden Zugriff auf Daten in europäischen Rechenzentren. Auch der Foreign Intelligence Surveillance Act (FISA) lasse einen solchen Datenzugriff zu. Die Gefahr, die von diesen Gesetzen für die Verwaltung ausgeht, diskutierte (PDF) auch der Landtag Baden-Württemberg im Sommer.

„Das hebelt europäisches Recht aus“, so von Brunn. Daher fordere die SPD in Bayern nicht nur „ein sofortiges Moratorium für den Microsoft-Deal“, sondern auch „einen verbindlichen Migrationsplan bis 2030 hin zu Open Source“. Diese Strategie sollte auch vorsehen, technologische Abhängigkeiten von einzelnen Konzernen überhaupt erst zu identifizieren, sagt Benjamin Adjei von den Grünen auf Anfrage. Um die „heimische Digitalwirtschaft“ zu stärken, brauche es außerdem jene finanziellen Mittel, die die bayerische Landesregierung in Lizenzkosten von Microsoft aufwende.

Gefahr „einer schutzlosen Preisgestaltung“

Inzwischen hat sich auch die SPD-Bundestagsfraktion in die Causa Microsoft eingeschaltet. In einem offenen Brief an Füracker positionieren sich deren digitalpolitischer Sprecher, Johannes Schätzl, der Landesvorsitzende der BayernSPD, Sebastian Roloff, und die Vorsitzende der SPD-Landesgruppe Bayern, Carolin Wagner, „gegen die Entscheidung, zentrale staatliche IT-Strukturen langfristig und ohne strategische Alternativenbewertung an einen einzelnen Anbieter zu binden“.