netzpolitik.org

Bitte aktualisieren Sie PHP auf Version 8.2.0 (zurzeit: 8.1.2-1ubuntu2.23). Info

Nach Temu ermittelt die EU-Kommission nun auch gegen einen zweiten Online-Händler aus China. Die Fast-Fashion-Plattform Shein unternimmt vermutlich zu wenig gegen die Risiken, denen sie ihre Nutzer*innen aussetzt. Zur Debatte stehen gleich mehrere Verstöße gegen den Digital Services Act.

Mit dem Digital Services Act (DSA) verpflichtet die EU sehr große Online-Plattformen, Risiken ihrer Angebote zu identifizieren und zu beheben. Weil der chinesische Fast-Fashion-Händler Shein diesen Vorgaben möglicherweise nicht ausreichend nachgekommen ist, hat die EU-Kommission nun ein Verfahren gegen das Unternehmen eröffnet. Das teilte sie am heutigen zweijährigen Geburtstag der EU-Verordnung über digitale Dienste mit.

Die Shopping-Plattform soll monatlich etwa 126 Millionen aktive Nutzer*innen in der EU haben. Seit Juni 2024 hatte die Kommission mehrfach Informationen von Shein angefragt. Die Entscheidung, eine Untersuchung einzuleiten, basiert auf diesen Auskunftsersuchen, auf einer vorläufigen Analyse der von Shein vorgelegten Risikobewertungsberichte und auf Einschätzungen dritter Parteien.

In Frankreich hatte sich im letzten Jahr bereits Widerstand gegen den Online-Händler geregt, jedoch war die französische Regierung mit dem Versuch gescheitert, die Plattform für drei Monate zu sperren.

„Illegale Produkte sind verboten“

Die Kommission attestiert dem Konzern Handlungsbedarf in drei Bereichen. An erster Stelle steht der Verkauf illegaler Waren, wegen dem der Fast-Fashion-Händler in der Vergangenheit bereits in Kritik stand. Zum Beispiel konnten genehmigungspflichtigen Waffen oder kinderähnliche Sexpuppen auf dem Marktplatz erworben werden.

Bei der Untersuchung geht es jedoch nicht darum, dass die EU gezielt den Verkauf einzelner Produktgruppen kontrollieren will. Vielmehr will sie dafür sorgen, dass die Plattform selbst ihre Systeme so gestaltet, dass Risiken minimiert werden. Konkret muss Shein also dafür sorgen, dass auf dem Marktplatz keine illegalen Waren gehandelt werden können.

„In der EU sind illegale Produkte verboten – egal, ob sie im Ladenregal oder auf einem Online-Marktplatz angeboten werden“, so EU-Kommissionsvizepräsidentin Henna Virkkunen zu dem Verfahren. „Der Digital Services Act schützt die Sicherheit und das Wohlergehen von Käufern und versorgt sie mit Informationen über die Algorithmen, mit denen sie interagieren.“

Ein zweiter Kritikpunkt betrifft mutmaßlich süchtig machendes Design des Online-Händlers. Er vergibt unter anderem Verbraucherpunkte oder Belohnungen für Engagement auf der Plattform. Das könne Suchtpotenzial entwickeln, welches sich negativ auf das Wohlbefinden der Nutzer*innen und den Verbraucherschutz im Internet auswirkt.

Außerdem kritisiert die Kommission mangelnde Transparenz des algorithmischen Empfehlungssystems von Shein. Dieses muss nach dem DSA zudem so gestaltet sein, dass sich Nutzer*innen optional für ein nicht-personalisiertes Empfehlungssystem entscheiden können.

EU ermittelt auch gegen Temu

Shein ist die zweite sehr große Plattform im Bereich Online-Handel, gegen die eine Untersuchung wegen süchtig machender Designpraktiken besteht. Bereits im Jahr 2024 hatte die EU-Kommission aus den gleichen Gründen ein Verfahren gegen Temu eröffnet.

Sollte die Kommission im Zuge der formalen Untersuchung zu einer Nichteinhaltungsentscheidung kommen, also einen tatsächlichen Verstoß gegen den DSA feststellen, kann sie zum Beispiel Bußgelder gegen das Unternehmen verhängen. Bis dahin ist es der Online-Plattform aber möglich, auf Forderungen zu reagieren und Anpassungen vorzunehmen. Wann es zu einer Entscheidung in dem Verfahren kommt, bleibt jedoch offen, denn der DSA schreibt hierfür keine Frist vor.

Der Online-Händler zeigt sich nach Angaben von Zeit.de bisher kooperationswillig: „Wir teilen das Ziel der Kommission, eine sichere und vertrauenswürdige Online-Umgebung zu gewährleisten, und werden uns weiterhin konstruktiv an diesem Verfahren beteiligen.“ Bei altersbeschränkten Produkten habe man bereits weitere Sicherheitsvorkehrungen ergriffen.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Seit zwei Jahren gelten neue Regeln für Plattformen in der EU. Die haben schon kleine Fortschritte bewirkt und machen Hoffnung. Aber um sie wirksam durchzusetzen, ist noch viel zu tun.

Der DSC-Beirat ist ein Gremium aus Zivilgesellschaft, Forschung und Wirtschaft. Er soll in Deutschland die Durchsetzung des Digital Services Act begleiten und den zuständigen Digital Services Coordinator unterstützen. Svea Windwehr ist Mitglied des Beirats und berichtet in dieser Kolumne regelmäßig aus den Sitzungen.

Seit dem 17. Februar 2024, also seit genau zwei Jahren, gilt in der EU der Digital Services Act. Das Regelwerk soll Nutzende schützen und mehr Transparenz und Fairness gegenüber Online-Plattformen und -Diensten schaffen. Gibt es etwas zu feiern?

Die Bilanz ist gemischt: Ein erstes Verfahren gegen X wurde zum Abschluss gebracht, viele andere Ermittlungen laufen noch. Die Rahmenbedingungen für Forschungsdatenzugang stehen endlich, in der Praxis gibt es aber noch massive Probleme. Zivilgesellschaft und Forschende haben unzählige Verfahren angestoßen und liefern wichtige Evidenz zu DSA-Verstößen, sind jedoch Repression und Delegitimierung ausgesetzt.

Pünktlich zum Geburtstag hat sich der neu berufene DSC-Beirat in neuer, kleinerer Konstellation zu seiner ersten gemeinsamen Sitzung getroffen und sich mit dem Stand der DSA-Durchsetzung beschäftigt. Der Beirat ist im Vergleich zu seiner letzten Besetzung geschrumpft, da die vier Vorschläge der AfD im Plenum des Deutschen Bundestages keine Mehrheit fanden. Deshalb und wegen der christ-demokratischen Definition von Zivilgesellschaft ist insbesondere von deren gesetzlich angedachter Stärke im Beirat des DSC nicht viel übrig geblieben.

Fortschritt in kleinen Schritten

Bei der Durchsetzung des DSA geht es nach wie vor oft schleppend voran. Der Koordinator für Digitale Dienste in Deutschland prüft noch, ob weitere außergerichtliche Streitbeilegungsstellen und Trusted Flagger zugelassen werden sollen. Während die Streitbeilegungsstellen etwa bei strittigen Moderationsentscheidungen zwischen Nutzer:innen und Plattformen vermitteln sollen, agieren die Trusted Flagger als vertrauenswürdige Hinweisgeber, deren Meldungen die Plattformen priorisiert bearbeiten sollen. Aktuell gibt es in Deutschland vier Organisationen, die als Trusted Flagger anerkannt sind, sowie zwei Streitbeilegungsstellen.

Von inzwischen insgesamt 30 durch den DSC eingeleiteten Verwaltungsverfahren gegen in Deutschland ansässige Plattformen wegen DSA-Verstößen scheint noch keines zum Abschluss gekommen zu sein. Und auch auf europäischer Ebene wurde seit der Verhängung eines Bußgelds gegen X im Dezember 2025 kein weiteres Verfahren zu Ende gebracht.

Immerhin kleine Fortschritte gibt es beim Datenzugang für Forschende. Nachdem detaillierte Hinweise, wie genau der Datenzugang ausgestaltet werden soll, Ende Oktober 2025 endlich in Kraft getreten sind, können Forschende Anträge auf Datenzugang bei ihren nationalen Aufsichtsbehörden stellen. Über dieses durch den DSA neu geschaffene Recht können sie zum ersten Mal qualitative und quantitative Daten von Plattformen anfragen, um systemische Risiken zu erforschen. Damit schafft der DSA längst überfällige Rahmenbedingungen, die unabhängige Forschung und ein besseres Verständnis von Online-Plattformen ermöglichen sollen – und potenziell wichtige Grundlagen für Durchsetzungsverfahren schaffen können.

Beim deutschen DSC sind seitdem immerhin neun Anträge auf Datenzugang eingegangen. Das klingt vielversprechend, allerdings wurden die meisten der neun Anträge wieder zurückgezogen, da die benötigten Daten auch über den niedrigschwelligeren Datenzugang über Schnittstellen der Plattformen angefragt werden konnten. Diese Möglichkeit, Daten über APIs anzufragen, funktioniert in der Praxis je nach Plattform durchwachsen bis schlecht – mangelnder Zugang zu Forschungsdaten ist einer der DSA-Verstöße, die zum Bußgeld gegen X beigetragen haben. Die Gesellschaft für Freiheitsrechte und Democracy Reporting International haben X kürzlich zum zweiten Mal deswegen verklagt.

Es ist also noch zu früh, um sich über große Durchbrüche beim Datenzugang zu freuen, aber immerhin können Forschende jetzt das System ausprobieren, Anträge stellen und auf Durchsetzung pochen, wenn die Plattformen sich weigern.

Ebenfalls hoffnungsvoll stimmen die kürzlich veröffentlichten vorläufigen Ergebnisse zu einem Verfahren gegen TikTok. Dort kommt die Europäische Kommission zu dem Schluss, dass die Videoplattform nicht genug getan hat, um Risiken von suchtfördernden Mechanismen insbesondere für Minderjährige zu mindern, beispielsweise endlose Feeds und hoch-personalisierte Empfehlungen. Das ist spannend, weil die Kommission davon ausgeht, dass TikTok das „grundlegende Design“ der Plattform ändern muss, um diesen Risiken beizukommen.

Sollte die Kommission bei dieser Einschätzung bleiben und nach Abschluss des Verfahrens Bußgelder gegen TikTok verhängen, hätte der Fall Auswirkungen weit über TikTok hinaus: Endlose Feeds und hoch-personalisierte Empfehlungen sind Kernelemente aller großen sozialen Netzwerke und Videosharingplattformen. Hier zeigt der DSA sein Potenzial, einerseits strukturelle Änderungen zu erstreiten, die das Businessmodell der Plattformen direkt betreffen. Das könnte zu anderen und besseren digitalen Räumen führen .

Andererseits zeigt die Argumentation, dass der DSA sinnvolle Werkzeuge bietet, um den Features und Plattform-Praktiken zu begegnen, die in der Debatte um Verbote von sozialen Medien für Kinder und Jugendliche im Fokus stehen: süchtigmachendes Design, Personalisierung basierend auf Unmengen persönlicher Daten, Produktdesign, das die Rechte und Interessen von Kindern wahrt.

Ein solches Verbot wurde Anfang Februar von Spaniens Premierminister Pedro Sanchez angekündigt, wofür er prompt von Elon Musk als Tyrann und Verräter Spaniens betitelt wurde. Daraufhin solidarisierte sich die Europäische Kommission mit Sanchez, während sie gleichzeitig festhielt, dass nur die Europäische Kommission durch den DSA weitere Verpflichtungen gegenüber sehr großen Online-Plattformen aussprechen darf. Angesichts des Eifers von Mitgliedstaaten wie Spanien, Italien, Griechenland, Frankreich und den Niederlanden bleibt abzuwarten, ob sich EU-Regierungen diesem Machtwort aus Brüssel beugen werden. Ob es also europäische Verboten von sozialen Medien geben wird, ist nach wie vor unklar.

Keine Durchsetzung ohne Repression

Solidarisch hatte sich die Europäische Kommission Ende Dezember auch gegenüber Mitgliedern eines angeblichen „globalen Zensur-industriellen Komplexes“ gezeigt, nachdem sie vom US-Außenministerium mit Visa-Sanktionen belegt worden waren, unter ihnen die beiden Geschäftsführerinnen von HateAid. HateAid ist eine der Organisationen, die als Trusted Flagger in Deutschland zugelassen sind.

Mit diesen Sanktionen markiert die Trump-Regierung Menschen als politische Feinde, die Online-Plattformen für Verstöße gegen geltendes Recht zur Verantwortung ziehen, bestraft sie und versucht, sie an ihrer Arbeit zu hindern.

Seit den Sanktionen gegen Zivilgesellschaft und Forschende vom Dezember hat ein neuer Bericht des Rechtsausschusses des US-Abgeordnetenhauses die Situation weiter verschärft. Die Beschäftigung des Ausschusses mit dem DSA ist getrieben von Jim Jordan, einem republikanischen Abgeordneten, der seit Jahren damit beschäftigt ist, die angebliche Zensur von US-Amerikaner:innen durch den DSA zu beweisen.

Auf 160 Seiten breitet der Bericht Jordans wirre Fantasie aus, dass die Europäische Kommission, unterstützt von der europäischen Zivilgesellschaft, nur ein Ziel mit dem DSA verfolge: die Unterdrückung konservativer, US-amerikanischer Stimmen. Dabei stützt sich der Bericht auf massenweise E-Mails, Screenshots und Dokumente, die Jordan durch Herausgabeverlangen von US-Plattformen bekam – wogegen sich Plattformen offensichtlich nicht oder kaum gewehrt haben.

Der Jordan-Bericht stellt jedoch nicht nur eine Reihe von Falschbehauptungen auf, sondern identifiziert und markiert auch eine ganze Reihe von Kommissionsmitarbeitenden und Vertreter:innen der Zivilgesellschaft, die an Workshops der Kommission zur DSA-Durchsetzung teilnahmen oder anderweitig an der Durchsetzung des DSA beteiligt sind. Ein gefundenes Fressen für jene Kräfte, die genau diese Arbeit verhindern wollen.

Die Repressionen gegen HateAid und Co. werden also wahrscheinlich nicht die letzten gegen Menschen und Organisationen gewesen sein, die sich um die Durchsetzung des DSA bemühen. Auf Seite der Behörden scheint man auch nach dem Shitstorm um Trusted Flagger und der Demontage des Stanford Internet Institute auf Druck rechtskonservativer Politiker kaum auf solche Szenarien vorbereitet sein – um nur zwei Beispiele zu nennen, in denen rhetorische Delegitimierungen durch rechte Akteure zu Einschüchterung, Gefahren für Einzelpersonen und dem Verlust von institutionellen Strukturen geführt haben.

Aufsichtsbehörden, Politik und die Kommission sind jetzt gefragt, nicht nur ihre Solidarität auszudrücken, sondern konkrete Maßnahmen zum Schutz von Zivilgesellschaft und Forschung zu ergreifen. Dabei darf aber nicht nur in die USA geschaut werden: Auch in Deutschland und anderen Mitgliedstaaten setzen konservative und rechte Kräfte die Zivilgesellschaft immer stärker unter Druck. Vom Anti-NGO-Kurs der Union über die Gemeinnützigkeitsdebatte und Kontoschließungen linker Organisationen bis zu physischen Angriffen gegen Aktivist:innen – wenn es er Politik ernst damit ist, zivilgesellschaftliche Arbeit zu schützen, darf sie nicht zwischen politisch genehmen und unbequemen Organisationen unterscheiden.

Ein ganzheitlicher Ansatz muss her: nachhaltige und großzügige Finanzierung, rechtliche Absicherung und vor allem eine Regierungspartei, die versteht, dass die Delegitimierung von NGOs letztlich nur einer Seite hilft – den Feinden demokratischer und offener Gesellschaften.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Das Bundesgesundheitsministerium hat in der vergangenen Woche ein Update zur Digitalisierungsstrategie des Gesundheitswesens vorgelegt. Die sogenannte Künstliche Intelligenz spielt darin eine zentrale Rolle. Umso wichtiger ist es, dass wir jetzt die richtigen Fragen stellen.

Die Versprechungen, die mit „Künstlicher Intelligenz“ („KI“) und mit Digitalisierung einhergehen, sind gewaltig. Das ist auch im „Update der Digitalisierungsstrategie für das Gesundheitswesen und die Pflege“ nicht anders, die Bundesgesundheitsministerin Nina Warken (CDU) am 11. Februar vorstellte. Ein „gesünderes und längeres Leben für alle“ soll die Digitalisierung ermöglichen, sie soll die medizinische Versorgung und Pflege „besser und effizienter“ machen, heißt es darin zum Beispiel.

Die Strategie hatte der damalige Minister Karl Lauterbach ursprünglich im Jahr 2023 vorgelegt. Der Aufbau des Europäischen Gesundheitsdatenraums (EHDS), neue Erwartungen im Bereich der „Künstlichen Intelligenz“ sowie der Plan eines neuen Systems für die Erstversorgung machten das nun vorgelegte Update notwendig.

Die wichtigsten Elemente: Die ePA soll zur zentralen Anwendung für Gesundheitsthemen ausgebaut werden, Digitalisierung der Schlüssel zu einem erfolgreichen Primärärzt*innensystem sein und „KI“ soll „sicher, flächendeckend und wirksam“ eingesetzt werden.

Digitalisierung und „KI“ werden das Gesundheitswesen fraglos verändern. Doch es ist wichtig, jetzt die richtigen Fragen zu stellen.

Wie weit hilft „KI“ dem Gesundheitswesen?

Während Digitalisierung und „KI“ durchaus das Potenzial haben, Prozesse im Gesundheitswesen zu vereinfachen und die Versorgung zu verbessern, kommt es auf eine gewissenhafte Abwägung bei der Umsetzung an.

Dabei dürfen wir vor allem nicht vernachlässigen, wie weitreichend die Auswirkungen auf Menschen in Gesundheitsberufen, auf Patient*innen und auf das Verhältnis zwischen ihnen sein können. Dazu braucht es mehr strategische Auseinandersetzung und Debatten.

Den großen Hoffnungen, mit denen der Einsatz von „KI“ derzeit verbunden ist, müssen wir realistisch begegnen. Weder wird „KI“ alle strukturellen Probleme im Gesundheitswesen wie Personalmangel oder Kostenexplosion lösen können. Noch sind die großen Versprechungen medizinischer Spitzenleistungen und Effizienzgewinne bisher eingetreten – oder auch nur auf absehbare Zeit erwartbar.

Die technische Architektur der KI-Systeme gründet auf massenhaften Daten plus Stochastik, also der mathematischen „Kunst des Vermutens“. Das begrenzt diese Systeme dauerhaft. Es gibt keine Garantie dafür, dass Aussagen der „KI“ wahr und richtig sind.

Anders als bei einem Algorithmus, der nach festen Regeln funktioniert und bei gleichen Bedingungen wiederholbare Ergebnisse liefert, ist diese Wiederholbarkeit bei „KI“ gerade nicht gewährleistet. Auch ist es nicht nachvollziehbar, was genau den jeweiligen Antworten zugrunde liegt.

Welche Zwecke soll und kann Dokumentation erfüllen?

„KI“-gestützte Dokumentation soll in wenigen Jahren bei mehr als 70 Prozent der Einrichtungen der Standard sein, heißt es in der Strategie.

Sicherlich: Dokumentation ist oft lästig, aber sie kann auch dabei helfen, ein gemeinsames Verständnis zwischen Patient*in und Ärzt*in herzustellen, Angaben zu überprüfen oder eine wichtige abschließende Reflexion über einen Fall darstellen.

Was bewirkt Automatisierung mit „KI“?

Doch selbst wenn eine Entlastung durch Automatisierung in diesem Fall naheliegt: Schafft sie am Ende tatsächlich mehr qualitativ hochwertige Zeit für die Behandlung von Patient*innen? Oder wird sie am Ende die Arbeit von Menschen in Gesundheitsberufen noch weiter verdichten?

Das ist gerade angesichts des demografischen Wandels erwartbar. Er wird in den nächsten Jahren dazu führen, dass viele ältere Patient*innen größere Behandlungsbedarfe in die Praxen und Krankenhäuser bringen, während zugleich viele Menschen in Gesundheitsberufen in Rente gehen. Weniger Ärzt*innen müssen also künftig mehr Patient*innen behandeln – wenn nicht gegengesteuert wird.

Dabei entscheidet eine gute Beziehung zwischen Ärzt*innen und Patient*innen über den Heilungsverlauf mit, auch bei körperlichen Erkrankungen. Doch dafür braucht es vor allem eines: Zeit.

So umfassend will Warken die Gesundheitsdaten aller Versicherten verknüpfen

Wie wichtig ist uns digitale Souveränität?

Bei der Automatisierung der Dokumentation strebt die Ministerin ein hohes Tempo an. Mit Blick auf die bisher auf dem Markt dominierenden Anbieter könnte das dazu führen, dass schon bald OpenAI, Google Gemini und Co. regelmäßig ebenfalls im Sprechzimmer anwesend sind. Die Abhängigkeit von den US-amerikanischen Tech-Konzernen wächst bei verstärktem Einsatz dieser Dienste also weiter an.

Große Anbieter von Praxisverwaltungssystemen werben bereits mit „KI“-Tools zur Dokumentation und Automatisierung. Schaut man genauer in deren Datenschutzbestimmungen, bestätigt sich diese Vermutung.

Doctolib setzt Anthropic und Google Gemini als „KI“ ein und hostet bei Amazon Web Services. Konkurrent Jameda begrüßt die neue Strategie als „wichtiges Signal für die Branche“ und verweist auf das eigene Dokumentationstool Noa Notes, das ebenfalls auf Amazon Web Services sowie Microsoft Azure setzt und auch OpenAI in seiner Datenschutzerklärung stehen hat.

VIA Health verspricht als „erster virtueller Assistent speziell für die Psychotherapie“ besten Datenschutz. Gleichzeitig weist das Unternehmen in seiner Datenschutzerklärung darauf hin, zur „Transkribierung der Audiospur sowie […] Erstellung der Sitzungsprotokolle“ verschiedene Drittanbieter von „Large Language Models (LLMs)“ einzusetzen.

Das alles spiegelt die gegenwärtige Realität weiter Teile unserer digitalen Infrastruktur wider. Zugleich passt es nicht zusammen mit politischen Forderungen nach mehr digitaler Souveränität, die auch von der Bundesregierung selbst regelmäßig vorgetragen werden.

Wie verändern Sprachmodelle die Beziehung zwischen Ärzt*innen und Patient*innen?

Auch zu „KI“-gestützten Systemen der medizinischen Ersteinschätzung müssen wir uns Gedanken machen. Künftig sollen Symptome in ein Computersystem eingegeben werden, danach erfolgt eine technische Einschätzung.

Dieses Verfahren soll Teil des Erstversorgungssystems werden und so den Zugang ins Gesundheitswesen (mit)regeln. Noch ist nicht klar, ob regelbasierte Algorithmen oder „KI“ die technische Grundlage dafür bilden werden.

Es kann grundsätzlich sinnvoll sein, vor dem Besuch einer Praxis die Symptome in ein technisches System einzugeben und sich gegebenenfalls aufgrund einer besseren Steuerung Wartezeit zu ersparen.

Eines genaueren Blicks bedürfen allerdings Themen, die sensibler und oft schambesetzt sind. Einfühlsam und ohne Vorurteile über Sexualität zu reden, fällt Menschen oft schwer. Viele Patient*innen sprechen das Symptom einer Geschlechtskrankheit daher erst am Ende einer Sprechstunde an. Oder eine psychische Belastungssituation wird erst im Laufe eines Gesprächs deutlich.

Öffnen wir mit digitalen Angeboten also tatsächlich neue Wege für Patient*innen? Oder verlieren wir etwas, wenn wir auf standardisierte digitale Ersteinschätzungen setzen? Und wie können geschützte Räume entstehen für sensible Themen wie Sexualität, Geschlechtskrankheiten, Substanzkonsum oder psychische Störungen, wenn das vertrauliche Gespräch mit einer behandelnden Person von einem „KI“-Tool mitgeschnitten wird?

Wie gut sind Sprachmodelle als Gesundheitsassistenzen wirklich?

„KI“ soll zur ständigen Begleiterin für Patient*innen werden und perspektivisch „individualisierte Gesundheitsempfehlungen“ geben, heißt es in der Strategie. Das Bundesgesundheitsministerium möchte so die Eigenverantwortung der Versicherten stärken.

Dabei hat gerade erst eine in der wissenschaftlichen Zeitschrift „Nature“ veröffentlichte Studie gezeigt, dass „KI“-Systeme faktisch daran scheitern, richtige Ergebnisse hervorzubringen, sobald man sich von theoretischem Lehrbuchwissen verabschiedet und reale Patient*innen auf sie loslässt.

Hinzu kommt: Bei Sprachmodellen, der Grundlage von KI-Systemen, werden die Eingaben nicht über Standardfragen geleitet. Sondern das Verfahren hängt stark von den Eingaben der User*innen ab – und damit die Ausgaben der Systeme.

Weil aber die Anzahl möglicher Nutzer*inneneingaben unbegrenzt ist, lässt sich damit auch nicht verlässlich für alle Anwendungsfälle überprüfen, wie gut ChatGPT und Co. im Einzelfall reagieren. Die Erwartung an Verlässlichkeit von Software-Programmen, die sich aus Zeiten regelbasierter Programmierung speist, ist bei auf Stochastik gründenden Ansätzen nicht haltbar – denn da sind immer Wahrscheinlichkeiten oder sogar der Zufall im Spiel.

Zwar gibt es mittlerweile Beispiele, in denen Menschen sagen: „KI“ hat mir dabei geholfen, dass es mir gesundheitlich wieder besser geht. Gerade bei seltenen Erkrankungen, denen Ärzt*innen in ihrem Berufsalltag nur überaus selten begegnen, wird den Sprachmodellen ein solches Potenzial zugesprochen.

Gleichzeitig gibt es jedoch groteske Beispiele, in denen ChatGPT bei der Bewertung von Daten eines Gesundheitstrackers die Note „ungenügend“ – also kurz vor Herzinfarkt – „erraten“ hat, während zwei Ärzte keine Anhaltspunkte für eine Erkrankung finden konnten.

Menschen handeln als Menschen und sind damit – auch in der Interaktion mit Maschinen und bei der Interpretation „maschineller“ Antworten – oft unberechenbar.

Das wiederum kann weitreichende Auswirkungen für Interaktionen zwischen Mensch und Mensch im Behandlungszimmer haben. Fragen Ärzt*innen in der Sprechstunde künftig mit ab, ob Patient*innen bereits vorab mit „KI“ recherchiert haben? Wie gehen Versicherte damit um, wenn sich Empfehlungen von „KI“-Systemen von denen realer Mediziner*innen unterscheiden? Oder wenn die von der „KI“ vorgeschlagenen Behandlungen nicht von den Kassen gedeckt werden?

Wie bleibt das Gesundheitswesen menschlich?

Wenn sie gut gemacht sind, bieten Technologien die Chance, Medizin besser zu machen. Dafür müssen wir uns allerdings die richtigen Fragen stellen – jenseits von Heilsversprechen und Technikgläubigkeit sowie im Wissen um den hochkomplexen Faktor Mensch.

Der Mensch ist dabei kein „nerviges Beiwerk“. Am Ende sollen es ja wir alle sein, die von den neuen Technologien profitieren – und nicht nur die Tech-Milliardäre, die sie mit den größten Versprechungen bewerben.

Manuel Hofmann ist Referent für Digitalisierung der Deutschen Aidshilfe. Offenlegung: Der Autor hat im vergangenen Jahr auf Einladung der Gematik am Fachforum „Technologien und Anwendungen“ für die Weiterentwicklung der Digitalisierungsstrategie „Gemeinsam Digital“ teilgenommen.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Bundesgesundheitsministerin Nina Warken hat ihre Digitalisierungsstrategie vorgelegt. Darin betont die CDU-Ministerin, die Patient:innensouveränität stärken zu wollen. Tatsächlich aber will sie eine der umfassendsten Gesundheitsdateninfrastrukturen weltweit aufbauen. Nutznießer sind Forschung und Pharma-Unternehmen. Die Rechte der Patient:innen bleiben auf der Strecke.

Rund 75 Millionen gesetzlich Versicherte, ihre Gesundheitsdaten täglich übermittelt an ein nationales Forschungsdatenzentrum, verknüpfbar mit hunderten Medizinregistern und europaweit vernetzt – das ist die Vision von Bundesgesundheitsministerin Nina Warken (CDU).

Die Ministerin präsentierte in der vergangenen Woche ihre „Digitalisierungsstrategie für das Gesundheitswesen und die Pflege“. Darin verspricht Warken eine bessere medizinische Versorgung und mehr Patientensouveränität. Tatsächlich aber zielt ihre Strategie vor allem darauf ab, eine der umfassendsten Gesundheitsdateninfrastrukturen weltweit aufzubauen.

Das knapp 30-seitige Papier legt zugleich die Grundlage für ein umfangreiches „Digitalgesetz“. Den Entwurf will das Bundesgesundheitsministerium (BMG) noch im laufenden Quartal vorlegen. Die Rechte der Patient:innen drohen darin weitgehend auf der Strecke zu bleiben.

Die geplante Dateninfrastruktur ruht auf drei Säulen: die elektronische Patientenakte, das Forschungsdatenzentrum Gesundheit und das geplante Medizinregistergesetz. Das Zusammenspiel aller drei Vorhaben ebnet auch der EU-weiten Vernetzung der Gesundheitsdaten den Weg.

Die ePA soll zur „Gesundheits(daten)plattform“ werden

Alle Versicherten, die nicht widersprochen haben, besitzen seit Januar 2025 eine elektronische Patientenakte (ePA); seit Oktober 2025 sind Behandelnde dazu verpflichtet, sie zu verwenden. Gesundheitsministerin Warken will die ePA nicht nur zum „zentralen Dreh- und Angelpunkt“ der ärztlichen Versorgung machen, sondern auch zur „Gesundheits(daten)plattform“ ausbauen.

Dafür sollen erstens mehr strukturierte Daten in die ePA fließen, die dann „möglichst in Echtzeit für entsprechende Anwendungsfälle nachnutzbar“ sind. Derzeit sind dort vor allem noch PDF-Dateien hinterlegt, die nicht einmal durchsuchbar sind, was den Umgang mit der ePA aus Sicht von Behandelnden deutlich erschwert.

Zweitens soll die ePA weitere Funktionen wie eine digitale Terminvermittlung und elektronische Überweisungen erhalten. Die Patientenakte soll so „auch interessanter werden für diejenigen, die nicht krank sind“, kündigte Warken an. Derzeit nutzen gerade einmal rund 4 Millionen Menschen ihre ePA aktiv. Bis zum Jahr 2030 soll sich ihre Zahl, so das Ziel des BMG, auf 20 Millionen erhöhen.

„Künstliche Intelligenz“ soll Symptome auswerten

Wer sich krank fühlt, soll künftig auch über die ePA-App eine digitale Ersteinschätzung einholen können. Mit Hilfe eines Fragenkatalogs sollen Versicherte dann erfahren, ob ihre Symptome den Gang zur Hausärztin oder gar zur Notfallambulanz rechtfertigen.

Diese Auswertung soll offenbar auch mit Hilfe sogenannter Künstliche Intelligenz erfolgen. Ohnehin soll KI laut Warken „in Zukunft da eingesetzt werden können, wo sie die Qualität der Behandlung erhöht, beim Dokumentationsaufwand entlastet oder bei der Kommunikation unterstützt“. Bis 2028 sollen beispielsweise mehr als 70 Prozent der Einrichtungen in der Gesundheits- und Pflegeversorgung KI-gestützte Dokumentation nutzen – ungeachtet der hohen Risiken etwa für die Patientensicherheit oder die Autonomie der Leistungserbringer.

Dafür will das BMG „unnötigen bürokratischen Aufwand“ für KI-Anbieter reduzieren. Das Ministerium strebt dafür mit Blick auf den Digitalen Omnibus der EU-Kommission „eine gezielte Anpassung der KI-Verordnung“ an. Das umstrittene Gesetzesvorhaben der Kommission zielt darauf ab, Regeln für risikoreiche KI-Systeme hinauszuzögern und den Datenschutz deutlich einzuschränken. Zivilgesellschaftliche Organisationen warnen eindringlich, dass mit dem Omnibus der „größte Rückschritt für digitale Grundrechte in der Geschichte der EU“ drohe.

Forschungsdatenzentrum soll als „Innovationsmotor“ wirken

Die in der ePA hinterlegten Daten sollen aber nicht nur der ärztlichen Versorgung dienen, sondern vor allem auch der Forschung zugutekommen. Sie sollen künftig – sofern Versicherte dem nicht aktiv widersprechen – täglich automatisch an das Forschungsdatenzentrum Gesundheit (FDZ) gehen. Während Warken die ePA als „Dreh- und Angelpunkt“ der Versorgung sieht, beschreibt sie das FDZ als „Innovationsmotor“ der Gesundheitsforschung.

Das FDZ wurde nach jahrelangen Verzögerungen im vergangenen Herbst erst handlungsfähig. Es ist beim Bundesamt für Arzneimittel und Medizinprodukte (BfArM) in Bonn angesiedelt. Forschende können sich bei dem Zentrum registrieren, um mit den dort hinterlegten Daten zu arbeiten. Auch Pharma-Unternehmen können sich bewerben. Eine Voraussetzung für eine Zusage ist, dass die Forschung einem nicht näher definierten „Gemeinwohl“ dient.

Die pseudonymisierten Gesundheitsdaten sollen das FDZ nicht verlassen. Stattdessen erhalten Forschende Zugriff auf einen Datenzuschnitt, der auf ihre Forschungsfrage abgestimmt ist. Die Analysen erfolgen in einer „sicheren Verarbeitungsumgebung“ auf einem virtuellen Desktop, das Forschende übers Internet aufrufen können.

Ob dabei tatsächlich angemessene Schutzstandards bestehen, muss indes bezweifelt werden. Denn das Forschungszentrum verfügte in den vergangenen Jahren nicht einmal über ein IT-Sicherheitskonzept, weshalb auch ein Gerichtsverfahren der Gesellschaft für Freiheitsrechte ruht.

Gemeinsam mit der netzpolitik.org-Redakteurin Constanze Kurz hatte die GFF gegen die zentrale Sammlung sensibler Gesundheitsdaten beim FDZ geklagt. Aus ihrer Sicht sind die gesetzlich vorgesehenen Schutzstandards unzureichend, um die sensiblen Gesundheitsdaten vor Missbrauch zu schützen. Sie verlangt daher für alle Versicherten ein voraussetzungsloses Widerspruchsrecht gegen die Sekundärnutzung der eigenen Gesundheitsdaten. Nachdem das FDZ seit Oktober den aktiven Betrieb aufgenommen hat, dürfte das ruhende Verfahren in Kürze fortgesetzt werden.

„Real-World-Überwachung“ ermöglichen

Dessen ungeachtet haben sich laut BfArM-Präsident Karl Broich bereits 80 Einrichtungen beim FDZ registriert. Die Antragsteller kommen zu gleichen Teilen aus Wirtschaft, Verwaltung und Forschung. Mehr als zwei Drittel von ihnen hätten bereits konkrete Forschungsanträge gestellt, bis zum Ende des Jahres will Warken diese Zahl über die Schwelle von 300 hieven. Alle positiv beschiedenen Anträge sollen künftig in einem öffentlichen Antragsregister einsehbar sein.

Zum Jahreswechsel wird das FDZ wohl auch über weit mehr Daten verfügen als derzeit. Bislang übermitteln die gesetzlichen Krankenkassen die Abrechnungsdaten all ihrer Versicherten an das Forschungszentrum. Diese geben bereits Auskunft darüber, welche Leistungen und Diagnosen die Versicherungen in Rechnung gestellt bekommen haben.

Ab dem vierten Quartal dieses Jahres sollen dann nach und nach die Behandlungsdaten aus der ePA hinzukommen. Den Anfang machen Daten aus der elektronischen Medikationsliste, anschließend folgen die Laborfunde, dann weitere Inhalte.

Der baldige Datenreichtum gibt dem FDZ aus Sicht von BfArM-Chef Broich gänzlich neue Möglichkeiten. Er geht davon aus, dass seine Behörde in zehn Jahren bundesweit „einer der großen Daten-Hubs“ ist. Mit den vorliegenden Daten könnten Forschende dann umfassende „Lifecycle-Beobachtungen“ durchführen – „eine Real-World-Überwachung also, die klassische klinische Prüfungen so nicht abdecken können“.

Auch im FDZ soll „Künstliche Intelligenz“ mitwirken. Zum einen in der Forschung selbst: „Dafür arbeiten wir an Konzepten, die Datenschutz, Sicherheit und wissenschaftliche Nutzbarkeit von Beginn an zusammendenken“, sagt Broich. Zum anderen soll das FDZ Datensätze etwa für das Training von Sprachmodellen bereitstellen, wie die Digitalisierungsstrategie des BMG ausführt und auch bereits gesetzlich festgeschrieben ist. Sowohl Training als auch Validierung und Testen von KI-Systemen sind eine zulässige Nutzungsmöglichkeiten. Das bedeutet konkret: Die sensiblen Gesundheitsdaten von Millionen Versicherten können zum Training von Sprachmodellen verwendet werden.

Wie „Künstliche Intelligenz“ unser Gesundheitswesen verändern soll – und welche Fragen das aufwirft

Warken will Medizinregister miteinander verknüpfen

Ab 2028 könnten Trainingsdaten dann auch detaillierte Daten zu Krebserkrankungen enthalten. Denn in knapp zwei Jahren sollen die FDZ-Datenbestände mit Krebsregistern sowie dem Projekt genomDE verknüpft werden, das Erbgutinformationen von Patient:innen sammelt.

Die Datenfülle beim FDZ dürfte damit noch einmal ordentlich zunehmen. Allein die Krebsregister der Länder Bayern, Nordrhein-Westfalen und Rheinland-Pfalz halten Daten von insgesamt mehr als drei Millionen Patient:innen vor. Wer nicht möchte, dass etwa die eigenen Krebsdaten mit den Genomdaten verknüpft werden, muss mindestens einem der Register komplett widersprechen.

Im Gegensatz etwa zu den Krebsregistern der Länder, die auf Basis spezieller rechtlicher Grundlagen arbeiten, bewegen sich die meisten anderen Medizinregister dem BMG zufolge derzeit „in einem heterogenen Normengeflecht von EU-, Bundes- und Landesrecht“, was „die Schaffung einer validen Datenbasis“ behindere.

Das Ministerium hat daher bereits im Oktober das „Gesetz zur Stärkung von Medizinregistern und zur Verbesserung der Medizinregisterdatennutzung“ auf den Weg gebracht. Der Referentenentwurf sieht vor, einheitliche rechtliche Vorgaben und Qualitätsstandards für Medizinregister zu schaffen.

Ein Zentrum für Medizinregister (ZMR), das ebenfalls am BfArM angesiedelt wäre, soll demnach bestehende Medizinregister nach festgelegten Vorgaben etwa hinsichtlich Datenschutz und Datenqualität bewerten. Qualifizierte Register werden dann in einem Verzeichnis aufgeführt, dürfen zu einem festgelegten Zweck kooperieren und auch anlassbezogen Daten zusammenführen. Die personenbezogenen Daten, die dort gespeichert sind, können für die Dauer von bis zu 100 Jahren in den Registern gespeichert werden.

Derzeit gibt es bundesweit rund 350 Medizinregister. Zu den größten zählen das „Deutsche Herzschrittmacher Register“, das die Daten von mehr als einer Million Patient:innen enthält, und das „TraumaRegister DGU“ mit Daten von mehr als 100.000 Patient:innen. Das Gesundheitsministerium geht davon aus, dass etwa drei Viertel der bestehenden Medizinregister Interesse daran haben könnten, in das Verzeichnis des ZMR aufgenommen zu werden.

Verbraucher- und Datenschützer:innen mahnen Schutzvorkehrungen an

Gesundheitsdaten, die dem ZMR vorliegen, sollen ebenfalls pseudonymisiert oder anonymisiert der Forschung bereitstehen. Das geplante Medizinregistergesetz sieht außerdem vor, dass die Daten qualifizierter Register ebenfalls miteinander verknüpft werden können.

Zu diesem Zweck sollen Betreiber von Medizinregistern und die meldenden Gesundheitseinrichtungen registerübergreifende Pseudonyme erstellen dürfen. Als Grundlage dafür soll der unveränderbare Teil der Krankenversichertennummer von Versicherten (KVNR) dienen.

Fachleute weisen darauf hin, dass eine Pseudonymisierung insbesondere bei Gesundheitsdaten keinen ausreichenden Schutz vor Re-Identifikation bietet. Das Risiko wächst zudem, wenn ein Datensatz mit weiteren Datensätzen zusammengeführt wird, wenn diese weitere personenbezogene Daten der gleichen Person enthält.

Das Netzwerk Datenschutzexpertise warnt zudem davor, die Krankenversichertennummer in einer Vielzahl von Registern vorzuhalten. Weil im Gesetzentwurf notwendige Schutzvorkehrungen fehlen würden, sei „das Risiko der Reidentifizierung bei derart pseudonymisierten Datensätzen massiv erhöht“.

Der Verbraucherzentrale Bundesverband kritisiert die Menge an personenbezogenen Daten, die laut Gesetzentwurf an qualifizierte Medizinregister übermittelt werden dürfen. Dazu zählen neben sozialdemographischen Informationen auch Angaben zu Lebensumständen und Gewohnheiten sowie „zu einem Migrationshintergrund oder einer ethnischen Zugehörigkeit, der Familienstand oder die Haushaltsgröße“.

Um die Patient:innendaten besser zu schützen, forderte der Verband bereits im November vergangenen Jahres, eindeutig identifizierende Daten vom Kerndatensatz eines Medizinregisters getrennt aufzubewahren.

Gesundheitsministerium schafft Schnittstellen in die EU

Das Gesundheitsministerium lässt sich davon jedoch nicht beirren und strebt weitere Datenverknüpfungen an. Laut seiner Digitalisierungsstrategie will das BMG das Forschungspseudonym auch dazu nutzen, um die Gesundheits- und Pflegedaten „mit Sozialdaten und Todesdaten zu Forschungszwecken“ sowie „mit Abrechnungs- und ePA-Daten“ zu verbinden. Ob Versicherte dieser umfangreichen Datenverknüpfung überhaupt noch effektiv und transparent widersprechen können, ist derzeit zweifelhaft. Sicher aber ist: Der Aufwand dürfte immens sein.

Die Digitalisierungsstrategie macht ebenfalls deutlich, dass das Ministerium die geplanten Maßnahmen auch in Vorbereitung auf den Europäischen Gesundheitsdatenraum (EHDS) ergreift. Der EHDS ist der erste sektorenspezifische Datenraum in der EU und soll als Blaupause für weitere sogenannte Datenräume dienen. Schon in wenigen Jahren sollen hier die Gesundheitsdaten von rund 450 Millionen EU-Bürger:innen zusammenlaufen und grenzüberschreitend ausgetauscht werden.

Konkret bedeutet das: In gut drei Jahren, ab Ende März 2029, können auch Forschende aus der EU beim FDZ Gesundheitsdaten beantragen. Und das Zentrum für Medizinregister soll dem BMG zufolge ebenfalls Teil der europäischen Gesundheitsdateninfrastruktur werden.

Der größte Brückenschlag in der Gesundheitsdateninfrastruktur steht also erst noch bevor. Und auch hier bleibt die Ministerin eine überzeugende Antwort schuldig, was die Versicherten davon haben.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Internetsperren sind ein zunehmend verbreitetes Werkzeug autoritärer Regierungen, um Informationen zu kontrollieren und abweichende Meinungen zu unterdrücken. Damit sind sie zu einer wachsenden Bedrohung für die Demokratie in Afrika geworden. Das sollte auch den Globalen Norden interessieren.

Die englischsprachige Version des Artikels ist hier zu finden: „Internet shutdowns in Africa: A human rights and democratic crisis“

Als die Menschen in Tansania im Oktober 2025 an die Wahlurnen gingen, wurde ihr Land von einem Informations-Blackout erfasst. Bereits am Vorabend der Wahlen kam es zu Einschränkungen der Internetverbindung, am Morgen des 29. Oktober meldeten dann alle Regionen einen vollständigen Ausfall der Datenverbindungen.

Oppositionsparteien gehörten zu den ersten, die Alarm schlugen. „Es war unmöglich geworden, Wahlbeobachter:innen zu koordinieren oder Unregelmäßigkeiten zu melden“, sagt Asha*, eine junge Aktivistin einer Oppositionspartei. Sie erklärt, dass die Beobachter:innen ihrer Partei aufgrund der Einschränkungen bei WhatsApp und SMS Fotos, Ergebnisse oder Beweise für Einschüchterungen nicht zeitnah weitergeben konnten.

Insgesamt waren in dem ostafrikanischen Land 37 Millionen Menschen dazu aufgerufen, ein neues Parlament und ein neues Staatsoberhaupt zu wählen. Im Vorfeld der Wahlen hatte Samia Suluhu Hassan, die amtierende Präsidentin und erste Frau in diesem Amt, ihren Griff um den Hals der Öffentlichkeit verstärkt. Kritische Journalisten und Oppositionspolitiker wurden entführt, die beiden aussichtsreichsten Oppositionsparteien von den Wahlen ausgeschlossen.

Der Shutdown schien alle Sorgen um die Integrität der demokratischen Prozesse zu bestätigen. Eine Wahlbeobachterin berichtet, dass sie während der Abschaltung miterlebt habe, wie beim Auszählen der Stimmzettel Zahlen addiert wurden. „Die Abschaltung war die endgültige Bestätigung dafür, dass wir es hier nicht mit transparenten Wahlen zu tun haben würden“, so Faustine*. „Ich gehörte zu den vielen, die während der Auszählung von der Polizei hinausgeworfen wurden.“

In den folgenden Tagen versuchten Aktivist:innen in Orten wie Mwanza und Arusha Menschen für Proteste zu mobilisieren, doch aufgrund fehlender Kommunikationsmittel war eine Massenmobilisierung nahezu unmöglich. Alle Demonstrationen, die trotz der Unterbrechung stattfanden, wurden brutal unterdrückt. Tansanias plötzliche Internetsperre veranschaulicht, wie Shutdowns zum sensibelsten Zeitpunkt demokratischer Prozesse Opposition verhindern und Regierungen nahezu vollständige Kontrolle über die Informationsverbreitung verschaffen können.

Hohe Kosten für Volkswirtschaften und Demokratien

Im Jahr 2016 verabschiedete der Menschenrechtsrat der Vereinten Nationen eine Resolution, die die Bedeutung des Internetzugangs für die Menschenrechte betont. Demnach untergraben Internet-Shutdowns die Meinungs-, Versammlungs- und Informationsrechte der Menschen.

Nur wenige Tage nach der Wahl in Tansania äußerte die Afrikanische Kommission der Menschenrechte und der Rechte der Völker sich besorgt über den digitalen Blackout. In einer Pressemitteilung erinnerte die Kommission daran, dass „Internet-Sperren zweifellos einen Verstoß gegen Artikel 9 der Afrikanischen Charta der Menschenrechte und Rechte der Völker darstellen, der Einzelpersonen das Recht auf Informationsempfang sowie das Recht auf freie Meinungsäußerung und Verbreitung von Informationen garantiert“.

Doch Tansanias Internet-Shutdown ist kein Einzelfall, sondern Teil eines größeren regionalen Musters: Immer wieder schalten afrikanische Regierungen in Zeiten politischer Instabilität die Internetversorgung ab. Auf dem gesamten Kontinent treten diese Störungen zu vorhersehbaren Zeitpunkten auf: bei Wahlen, regierungskritischen Protesten, Militärputschen, ethnischen Konflikten oder wenn journalistische Recherchen die staatliche Autorität gefährden. Regierungen rechtfertigen Sperrungen oft mit Argumenten wie Sicherheit, Stabilität und „Fake News“, doch ihr eigentliches Ziel ist es, Informationen zu kontrollieren und abweichende Meinungen zu unterdrücken.

Jährliche Berichte der von Access Now koordinierten #KeepItOn-Koalition zeigen, dass afrikanische Staaten weltweit zu den Ländern mit den meisten Shutdowns gehörten. Der neueste #KeepItOn-Report belegt, dass 2024 das Jahr mit den meisten Internet-Abschaltungen in der Region war, mit 21 dokumentierten Abschaltungen in 15 afrikanischen Ländern. Erst vor wenigen Wochen, parallel zum Kommunikations-Shutdown im Iran, mussten auch die Menschen in Uganda während der Wahlen eine Internetsperre erdulden.

In allen Fällen sind diejenigen Personen am stärksten betroffen, die im Zentrum der demokratischen Teilhabe stehen: Aktivist:innen, Journalist:innen, humanitäre Helfer:innen, Oppositionelle und junge Wähler:innen. Die Folgen gehen über Zugangsprobleme zur digitalen Welt hinaus und führen zu wirtschaftlicher Lähmung, humanitärer Isolation und zur Aushöhlung grundlegender Rechte. Die Arbeit von Journalist:innen wird unmöglich, Unternehmen, die Online-Plattformen oder mobiles Geld für ihren Betrieb nutzen, erleiden große Verluste; Krankenhäuser und humanitäre Helfer:innen verlieren in kritischen Momenten den Kontakt zur Außenwelt.

Laut dem Cost of Shutdown Tool (COST) der Organisation NetBlocks kosteten Internetabschaltungen allein die tansanische Wirtschaft im Jahr 2025 mehr als 238 Millionen US-Dollar. Insgesamt werden die Kosten von Internetabschaltungen für die Volkswirtschaften südlich der Sahara in diesem Jahr auf 1,11 Milliarden US-Dollar geschätzt. Noch schwerer wiegen jedoch die Kosten für die Demokratie.

Äthiopien: Mehr als 100 Millionen Menschen offline im Bürgerkrieg

In den vergangenen Jahren war Äthiopien mit über zehn dokumentierten Abschaltungen seit 2019 einer der größten Übeltäter für vorsätzliche Internet-Shutdowns in Afrika. Zwischen 2020 und 2022 wurden insbesondere die Regionen Tigray und Oromia in physische und digitale Isolation gestürzt. Während des Bürgerkriegs verhängte die Regierungen mehrere Abschaltungen, die nicht nur Dissidenten zum Schweigen brachten, sondern auch humanitäre Hilfe erschwerten.

Die Vereinten Nationen berichteten, dass von einem dreiwöchigen Shutdown im Juli 2020 mehr als 100 Millionen Menschen betroffen waren. Wie Berichte der #KeepItOn-Koalition hervorheben, fiel jede Abschaltung mit einer Eskalation der Gewalt zusammen. Ein Muster, das darauf hindeutet, dass das Ziel nicht „Sicherheit”, sondern strategische Unsichtbarkeit war.

Das Committee to Protect Journalists (CPJ) gehört zu den Organisationen, die die Inhaftierung von Journalisten und die gezielte Internetabschaltung verurteilten. In einem Land, in dem digitales Banking, Bildung und Katastrophenhilfe zunehmend auf Konnektivität angewiesen sind, lähmten diese Abschaltungen das Leben der Menschen.

Sudan: Shutdowns als Unterstützung für einen Militärputsch

Ein weiteres Beispiel ist der Sudan, wo Internet-Shutdowns die Geschichte der Militärherrschaft geprägt haben. Von 2019 bis 2023 hat die Regierung wiederholt den Zugang zum Internet gesperrt, um die Mobilisierung von Protesten und Reaktionen auf einen Staatsstreich einzuschränken. So zum Beispiel im Oktober 2021, als die Armee die zivile Führung festgenommen und den Internetzugang im gesamten Sudan abgeschaltet hat.

Die sudanesische Bevölkerung konnte fast einen Monat lang nicht mit Menschen innerhalb oder außerhalb des Sudan kommunizieren. Die Organisator:innen von Protesten waren auf Offline-Netzwerke und direkten Kontakt angewiesen, um Informationen in den Stadtvierteln weiterzugeben und Demonstrationen zu organisieren. Videos von militärischer Gewalt und Massenverhaftungen wurden wochenlang nicht hochgeladen, sodass die Armee ungestraft handeln konnte.

Human Rights Watch und andere Menschenrechtsorganisationen bezeichneten diese Störungen als vorsätzliche Behinderung der Justiz. Die Sperrung behinderte nicht nur den Informationsfluss, sondern unterdrückte den gesamten zivilgesellschaftlichen Handlungsspielraum. Laut Human Rights Watch hat die Präsenz von Militärkräften in Krankenhäusern den Zugang zu medizinischer Versorgung für Bedürftige beeinträchtigt oder verhindert, und „Mediziner sagten, dass der fehlende Internetzugang es ihnen noch schwerer gemacht habe, die Versorgung zu organisieren“. Auch die Arbeit von humanitären Helfer:innen wurde dadurch beeinträchtigt, dass sie keine Geldüberweisungen über Mobile-Banking-Apps empfangen konnten.

Ein Werkzeug für autoritäre Kräfte

Äthiopien und Sudan unterscheiden sich zwar politisch und kulturell, doch die zu beobachtende Vorgehensweise bei der Abschaltung von Kommunikationsdiensten ist ähnlich. Beide Regierungen nutzten Einschränkungen der Konnektivität nicht nur als vorübergehende Sicherheitsmaßnahmen, sondern auch als langfristige Strategien, um die öffentliche Debatte und die Verbreitung von Informationen zu kontrollieren.

Darüber hinaus schränken die Abschaltungen auch die Möglichkeiten von Oppositionsparteien und zivilgesellschaftlichen Gruppen ein. In vielen afrikanischen Ländern stützt sich die Opposition hauptsächlich auf Messaging-Apps, kostengünstige Livestreams und von Bürger:innenn geführte Wahlbeobachtungsnetzwerke.

Wenn diese Kanäle nicht mehr funktionieren, können Oppositionsparteien keine Wahlbeobachter:innen koordinieren, keine Beweise sammeln und keine Krisenteams entsenden. Auch zivilgesellschaftliche Kontrollinstanzen können die Wahlergebnisse nicht überprüfen, was den Regierungsparteien Spielraum für Manipulationen lässt. Darüber hinaus verlieren insbesondere Frauen und junge Aktivist:innen, die sich hauptsächlich online organisieren, ihre Mobilisierungsmacht. Organisator:innen an der Basis sind zusätzlich physischen Gefahren ausgesetzt, weil sie auf die Kommunikation von Tür zu Tür zurückgreifen müssen.

In Tansania berichteten Wahlbeobachter:innen, dass die Sperrung und die Schikanen durch die Polizei zu einer tiefen psychischen Erschöpfung geführt hätten. „Wir fühlten uns während des gesamten Prozesses machtlos“, erzählt uns Faustine*. „Es war nicht nur ein technisches Hindernis, sondern führte dazu, dass viele undemokratische Vorgänge in den Wahllokalen verschleiert wurden.“

Wie die Zivilgesellschaft Widerstand leistet

Zivilgesellschaftliche Organisationen in Afrika und anderen Teilen der Welt haben deutlich gemacht, dass Internet-Sperren ein wachsendes Menschenrechtsproblem darstellen, und organisieren Widerstand dagegen. So fechten beispielsweise die nigerianische Paradigm Initiative und die in Uganda ansässige CIPESA die Sperrung von Diensten vor Gericht an. Sie klären die Bürger über zivilen Ungehorsam, digitale Rechte und den Umgang mit Technologie auf.

Dutzende von NGOs haben die Afrikanische Erklärung der Internetrechte und -freiheiten unterzeichnet, die einen uneingeschränkten Internetzugang für die Region fordert. Leider haben die Regierungen diese Erklärung ignoriert. Neben Kontrolle ist auch die mangelnde Transparenz ein Problem. Berichte und Daten werden oft von globalen Initiativen wie der #KeepItOn-Koalition von Access Now zusammengestellt.

Der Einfluss der Zivilgesellschaft ist zwar oft indirekt, hat jedoch zunehmend rechtliche und politische Konsequenzen für Regierungen, die Abschaltungen verhängen. Laut Felicia Anthonio, #KeepItOn Global Campaign Manager bei Access Now, hat anhaltende Lobbyarbeit dazu geführt, dass Internet-Shutdowns überhaupt auf der globalen Menschenrechtsagenda stehen und dass regionale und internationale Gremien sie nun als Verletzung von Grundrechten anerkennen.

Gerichte wie der Gerichtshof der Westafrikanischen Wirtschaftsgemeinschaft ECOWAS haben gegen Abschaltungen in Ländern wie Togo, Nigeria, Senegal und Guinea entschieden und damit, so Anthonio, eine klare Botschaft gesendet, dass Internet-Shutdowns illegal sind und die Verantwortlichen zur Rechenschaft gezogen werden können.

Über Rechtsstreitigkeiten hinaus habe der Druck der Zivilgesellschaft auch dazu geführt, dass Regierungsbehörden in Ländern wie Ghana, Kenia und der Demokratischen Republik Kongo sich öffentlich dazu verpflichtet haben, das Internet während Wahlen aufrechtzuerhalten. Zudem seien Internet-Sperren in Ländern wie Sambia, Südsudan und Mauritius rückgängig gemacht oder vorzeitig beendet worden, erzählt die Aktivistin. Zwar hätten Regierungen nach wie vor die Macht, das Internet abzuschalten. Doch die Zivilgesellschaft arbeite stetig daran, Rechtsnormen, die öffentliche Meinung und Rechenschaftspflichten dahingehend zu anzupassen, damit Internet-Sperren der Vergangenheit angehören.

Was der Globale Norden tun kann

Internet-Shutdowns sind zwar ein „lokales Problem“ im Kontext autoritärer Staaten, doch eine regionale und afrikaweite Normalisierung kann auch zu einem Export autoritärer Methoden führen. Jede Internetsperre legitimiert und stärkt autoritäre Bestrebungen in Nachbarländern, sodass sie inzwischen auch in vermeintlich demokratischen Staaten zu beobachten sind.

Um Shutdowns zu unterbinden, bedarf es deshalb auch Druck von außerhalb des Kontinents. Westliche Regierungen und Technologieunternehmen verurteilen solche Störungen zwar oft, doch ihre Reaktionen bleiben meist symbolisch. Es gibt jedoch Ideen, wie Länder des Globalen Nordens einen tiefergehenden positiven Einfluss ausüben könnten.

Allen voran könnten sie den Export von Überwachungs- und Zensurwerkzeugen einstellen, die Shutdowns ermöglichen. Darüber hinaus könnten sie Gelder der Entwicklungshilfe an den Schutz digitaler Rechte knüpfen und so sicherstellen, dass Regierungen, die Unterstützung erhalten, nicht gleichzeitig Kommunikationsnetzwerke sabotieren können, ohne dass dies Konsequenzen hat. Auch die Unterstützung lokaler zivilgesellschaftlicher Gruppen ist wichtig, beispielsweise durch die Finanzierung von Schulungen zur digitalen Sicherheit oder durch Rechtsbeistand bei Gerichtsverfahren.

Wie Sophia Nabalayo, eine kenianische PR- und Kommunikationsspezialistin, gegenüber netzpolitik.org erklärt: „Afrikanische Aktivist:innen können vor Ort gegen Abschaltungen kämpfen, aber globale Akteure kontrollieren oft die Infrastruktur und die Finanzmittel, die Abschaltungen erst möglich machen. Wir brauchen Solidarität, nicht nur Erklärungen.“

* Die Namen wurden aus Sicherheitsgründen geändert und sind der Redaktion bekannt.

Über den Autor: Derrick Wachaya ist Kommunikationsexperte für Klimaschutz und freiberuflicher Journalist in Nairobi.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Internet shutdowns have become a growing threat to Africa’s democracy. They are an increasingly common part of the authoritarian toolkit used by governments to control information and suppress dissent. Here’s why you should care.

A German version of the article can be found here: „Internet-Shutdowns in Afrika: Eine Krise für Menschenrechte und Demokratie“

As Tanzanians went to the polls in October 2025, the country entered an information blackout. Connectivity began slowing on the eve of the election. By the morning of October 29, all regions reported a full data disruption.

Opposition parties were among the first to raise the alarm. ‘It became impossible to coordinate polling agents or even report irregularities,’ says Asha*, a youth organizer with an opposition party. She explains that with WhatsApp and SMS restricted, their party’s observers could not share photos, results, or evidence of intimidation in real time.

In the East African country, a total of 37 million people were called upon to vote for a new parliament and president. In the run-up to the elections, Samia Suluhu Hassan, the incumbent president and first woman to hold the office, had tightened her grip on the public sphere. Critical journalists and opposition politicians had been kidnapped. The two most promising opposition parties were excluded from the election.

The communications shutdown seemed to confirm fears about the integrity of the most important democratic processes. An election observer described witnessing the ticking of ballot papers and the adding of numbers during the shutdown. ‘The blackout was the final confirmation that this election would not be transparent, and I was among many who were kicked out by the police during counting,’ says Faustine*, an observer during the election.

Days later, protesters in Mwanza and Arusha attempted to demonstrate, but the lack of communication tools made mass mobilization nearly impossible. Any demonstrations that did emerge despite the blackout were brutally suppressed. Tanzania’s sudden disconnection, occurring during the most sensitive democratic moment, illustrates how shutdowns immobilize opposition networks while giving governments near-total narrative control.

High costs to economies and democracies

In 2016, the United Nations Human Rights Council adopted a resolution confirming the importance of internet access for human rights. Internet shutdowns, it says, undermine the expression, assembly, and informational rights of citizens.

Only days after the election in Tanzania, the African Commission on Human and Peoples‘ Rights voiced concern about the digital blackout. The commission issued a press release, reminding everyone that ‘internet shutdowns undoubtedly constitute a violation of Article 9 of the African Charter on Human and Peoples’ Rights, which guarantees individuals the right to receive information, as well as the right to express and disseminate information.’

Tanzania’s blackout, however, is not an isolated case but part of a regional pattern: governments cutting connectivity during moments of political vulnerability. Across the continent, these disruptions occur at predictable moments: elections, anti-government protests, military coups, ethnic conflict, or when investigative journalism threatens state legitimacy. Governments often justify shutdowns using the language of security, stability, and ‚fake news‘, but the purpose is to control information and suppress dissent.

Access Now’s #KeepItOn coalition reported that African states, including Tanzania, accounted for some of the highest global disruptions in recent years. Their latest report shows that 2024 saw the highest number of shutdowns ever recorded in a single year for the region, with 21 documented internet access shutdowns in 15 African countries. Just a few weeks ago, at the same time as the communications blackout in Iran, people in Uganda also had to endure another internet shutdown during elections.

In all cases, the people most affected – activists, journalists, humanitarian responders, opposition politicians, and young voters – are those at the heart of democratic participation. The outcomes extend beyond digital access challenges, including economic paralysis, humanitarian isolation, and the erosion of fundamental rights. The work of journalists becomes impossible, businesses that use online platforms or mobile money to operate lose significant revenue, and hospitals and humanitarian workers lose contact with the outside world during critical moments.

According to the organization NetBlocks Cost of Shutdown Tool (COST), internet shutdowns cost the Tanzanian economy more than US $238 million in 2025. In total, it is estimated that internet shutdowns cost sub-Saharan economies US $1.11 billion that year. But ultimately, the cost to democracy is even greater.

Ethiopia: More than 100 million people offline during civil war

In recent years, one of the worst offenders for intentional internet disruptions in Africa was Ethiopia, with over ten documented shutdowns since 2019. Between 2020 and 2022, Ethiopia’s regions of Tigray and Oromia were plunged into physical and digital isolation. Government-imposed shutdowns during the civil war not only silenced dissent but cut off humanitarian efforts.

The UN reported that over 100 million people were affected during a three-week internet shutdown in July 2020. As reports by the #KeepItOn coalition highlight, each blackout coincided with escalations in violence, a pattern that suggests the intent was not ‘security,’ but strategic invisibility.

The Committee to Protect Journalists (CPJ) was among the organizations to condemn the detention of journalists and the internet blackout. In a country where digital banking, education, and emergency response increasingly rely on connectivity, these shutdowns paralyzed people’s lives.

Sudan: Shutdowns in support of a military coup

Another example is Sudan, where internet shutdowns have marked a history of military rule. From 2019 to 2023, the government repeatedly cut access to the internet to limit the mobilization of protests and responses to coups. For instance, the army detained civilian leadership in October 2021 and cut internet access across the country.

The Sudanese people were left without any way to communicate with people inside or outside the country for almost a month. Protest organizers relied on offline networks and direct contact to pass information across neighborhoods to organize protests. Videos of military violence and mass arrests were delayed for weeks, allowing the army to act with impunity.

Human Rights Watch and other rights organizations labelled these disruptions as intentional hindrances to justice. The cutoff did more than thwart information; it stifled the civic space altogether. According to Human Rights Watch, the presence of military forces at hospitals has undermined or prevented access to medical care for those in need, and „medical professionals said the lack of internet access has only made it more difficult for them to organize ways to provide care.“ The work of emergency responders was also affected by the inability to receive money transfers via mobile banking applications.

A tool for authoritarian forces

While Ethiopia and Sudan differ politically and culturally, their shutdown patterns are similar. Both governments used connectivity restrictions not only as temporary security tools but also as long-term strategies to manage information and public situations.

Beyond the immediate disruption of communication, shutdowns also affect the options of opposition parties and civil society groups. In many African countries, opposition relies mostly on messaging apps, low-cost livestreaming, and citizen-led election monitoring networks.

When these channels go dark, opposition parties cannot coordinate polling agents, collect evidence, or deploy rapid response teams. Civil society watchdogs cannot verify electoral tallies, giving ruling parties space to manipulate results. Furthermore, especially women and youth activists, who organize primarily online, lose their mobilizing power. Grassroots organizers face physical danger, as they must revert to door-to-door communication.

In Tanzania, polling agents and observers reported that the blackout and police harassment created deep psychological fatigue. ‘We felt powerless throughout the process,’ says election observer Faustine*. ‘It wasn’t just technical, it silenced many things that happened in polling stations that are undemocratic.’

How civil society pushes back

Civil society organizations in Africa and elsewhere have made it clear that internet shutdowns are a growing human rights issue and are organizing resistance. For example, the Nigerian Paradigm Initiative as well as Uganda-based CIPESA challenge service suspensions in court. They educate citizens about civil disobedience, digital rights, and how to utilize technology.

Dozens of NGOs have signed onto the African Declaration of Internet Rights and Freedoms, which calls for unrestricted internet access across the region. Unfortunately, this declaration has been ignored by governments. Along with controls, the absence of transparency is a problem. Reports and data are often compiled by global initiatives, such as Access Now’s #KeepItOn coalition.

Civil society’s influence, while often indirect, has increasingly translated into legal and political consequences for governments that impose shutdowns. According to Felicia Anthonio, #KeepItOn Global Campaign Manager at Access Now, sustained advocacy has pushed internet shutdowns onto the global human rights agenda, with regional and international bodies now recognizing them as violations of fundamental rights.

Courts such as the ECOWAS Court have ruled against shutdowns in countries including Togo, Nigeria, Senegal and Guinea, sending what Anthonio describes as a clear message that shutdowns are illegal and those responsible can be held accountable.

Beyond litigation, civil society pressure has also led to public commitments by authorities to keep the internet on during elections in countries like Ghana, Kenya and the Democratic Republic of the Congo, as well as reversals or early terminations of shutdowns in places such as Zambia, South Sudan and Mauritius. While governments still hold the power to disconnect, civil society continues to shape legal norms, public opinion and accountability mechanisms aimed at ending shutdowns altogether.

What the Global North can do

Shutdowns are a ‘local issue’ in the context of authoritarian states; however, the regional and continent-wide normalization of shutdowns can lead to an export of authoritarian behaviors. Each shutdown legitimizes and emboldens further authoritarianism in neighboring countries, so that they are increasingly seen in networks of purportedly democratic states.

Stopping shutdowns requires pressure beyond the continent. Western governments and tech companies often condemn disruptions, but their responses often remain symbolic. There are ways, however, in which countries in the Global North could have a more profound positive influence.

First and foremost, they could stop exporting surveillance and censorship tools that allow shutdowns to be implemented. Furthermore, they could tie development funding to digital rights protections, ensuring governments that receive aid cannot also sabotage communication networks without consequences. Support for local civil society groups is also important, for example through funding digital security training or legal assistance for court challenges.

As Sophia Nabalayo, a Kenyan PR & Communications Specialist, tells netzpolitik.org: ‘African activists can fight shutdowns on the ground, but global actors often control the infrastructure and financing that make shutdowns possible. We need solidarity, not just statements.’

* Names have been changed for safety reasons and are known to the editorial team.

About the author: Derrick Wachaya is a climate communicator and freelance journalist based in Nairobi.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

In Los Angeles stehen Meta und Google vor Gericht, in der EU muss TikTok nachschärfen. In beiden Fällen geht es um ihr süchtig machendes Design. Das verweist auf einen besseren Weg im Kinder- und Jugendschutz: Ursachenbekämpfung statt Verbote. Ein Kommentar.

„Ich male mir die Welt, so wie sie mir gefällt.“ – Das gelingt den Plattformbetreibern hinter Instagram, Youtube, Snapchat oder TikTok bisher ganz gut. Das in Los Angeles eröffnete Verfahren könnte an diesem Prinzip jedoch rütteln und zeigen, dass es etwas anderes als ein Verbot für Jugendliche braucht, um die negativen Effekte sozialer Medien zu reduzieren.

Die 20-jährige Hauptklägerin will Meta und Google für ihr süchtig machendes Design zur Verantwortung ziehen. Vor Gericht gibt sie an, seit über zehn Jahren von sozialen Medien abhängig zu sein – einem Effekt, dem sich die Unternehmen laut interner Dokumente bewusst waren. Und wenn man ehrlich ist: Es ist ein Effekt, den die kommerziellen Plattformen wollen, damit sich die Aufenthaltszeit auf Plattformen verlängert, sie mehr Werbung an die Nutzer*innen abspielen und so mehr Gewinne einfahren können.

Wenn in den USA eine Person vor Gericht geht, deren Generation bisher am frühesten in der digitalen Welt aufgewachsen ist, führt das unweigerlich zu der Frage, wie für diese und nachfolgende Generationen eine bessere und andere Version von sozialen Medien aussehen könnte. Denn ob mit dem Verfahren letztlich ein Präzedenzfall geschaffen werden kann oder nicht – der Prozess stärkt eine andere Stoßrichtung als das derzeit heiß diskutierte Social-Media-Verbot.

Ein Verbot ist die falsche Antwort

Von einem Verbot sozialer Medien für junge Menschen werden viele negative Effekte erwartet: Für Minderheiten oder vulnerable Gruppen fällt ein Kanal zur Vernetzung und Gemeinschaftsbildung weg, ebenso ein Kanal zur Information, Menschen ohne Papiere könnten ganz ausgeschlossen sein und auf Kinder und Jugendliche entfallen die Folgen je nach Familiensituation und Wohnort ungleich.

Diese Nebeneffekte müssten weniger ins Gewicht fallen, wenn unterm Strich auf den Plattformen und ohne Verbot das ursprüngliche Ziel erreicht werden würde: Schutz von Kindern und Jugendlichen vor digitalem Missbrauch, vor Mobbing sowie übermäßigem Konsum und Sucht.

Ein Blick nach Australien zeigt, dass Verbote einerseits löchrig bleiben und andererseits große Risiken für Privatsphäre und Datenschutz bergen. Wie die australische Regierung erwartet hatte, finden Jugendliche einfach Schlupflöcher, das Verbot zu umgehen. Sie ändern ihren Standort über VPN-Verbindungen, legen sich neue Accounts an, wechseln auf nicht betroffene Apps oder nutzen Accounts von älteren Personen. Mit KI-generierten Bildern, Ausweisen von Älteren oder durch einfaches Stirnrunzeln bestehen sie Altersabfragen, die jetzt zur Architektur von Plattformen dazugehören.

Sollte die australische Regierung an diesen Stellen nachschärfen, bleiben Alterskontrollen aus datenschutzrechtlicher Perspektive trotzdem bedenklich. Ein vorab durchgeführtes Gutachten verzeichnet massive Bedenken, wie erhobene Daten gesammelt und an Behörden weitergegeben werden könnten. Das ist der eine Fall. Der andere Fall ist auch datenschutzrechtlich problematisch, wenn personenbezogene Daten aus Alterskontrollen an Drittanbieter weitergegeben werden, wie der Fall von Discord deutlicht.

Plattformen in die Pflicht nehmen statt Probleme in die Zukunft verlagern

Der Medienrechtler Stephan Dreyer erwartet, dass ein EU-Verbot den Jugendschutz auf sozialen Plattformen verschlechtern würde, wie er gegenüber netzpolitik.org darlegte.

Dazu kommt: Soziale Medien sind allgegenwärtiger Teil des Lebens auf der ganzen Welt. Haben Jugendliche die magische Grenze von 16 Jahren überschritten, sind sie zusammen mit den Älteren weiterhin endlosen Feeds, manipulativem Design, personalisierten Empfehlungssystemen und Dopamin-Kicks ausgesetzt. Statt „Cybergrooming“ heißt die Gefahr dann „digitale Gewalt“, wie der Grok-Skandal gerade deutlich vor Augen geführt hat.

Und warum eigentlich nur Jugendliche? Sind nicht auch gestandene Mittvierziger dem suchtmachenden Design der Plattformen verfallen und geraten nicht auch Boomerinnen in den Strudel, der sie in den verschwörungsideologischen Kaninchenbau zieht? Werden nicht uns allen polarisierende Inhalte von intransparenten Algorithmen gezeigt, damit wir möglichst lange mit den Plattformen interagieren und sie uns mit personalisierter Werbung zuballern können.

Bessere Plattformen für alle

Ein Verbot für Jugendliche macht die Plattformen nicht besser. Anstatt Plattformen zur Umsetzung von Alterskontrollen zu zwingen und junge Menschen auszuschließen, müssen die Plattformen zu einer anderen Architektur verpflichtet werden. Fairness by Design und by Default nennt sich der Ansatz, der digitale Plattformen dazu verpflichtet, ihre Webseiten und Apps nutzerfreundlich und manipulationsfrei zu gestalten. Die EU ist gegenüber TikTok einen Schritt gegangen, aber die Liste an manipulativen Techniken ist lang.

Ein Verbot ist letztlich eine platte und hilflose Maßnahme. Es erinnert an überforderte Eltern, die den Kindern das Handy wegnehmen, weil sie nicht weiterwissen. Dabei könnten auch die Verbotsbefürworter*innen beim Ansatz Fairness by Design auf ihre Kosten kommen. Er wäre einer von mehreren Ansätzen, die Plattformen nachhaltig zu verändern. Und es gibt Gesetzgebungen wie das Digitale-Dienste-Gesetz oder wie das geplante Gesetz für digitale Fairness, mit denen man Plattformen verändern kann.

Die Politik muss sich nur trauen – und nicht weiter vor der Lobby der Tech-Riesen einknicken.

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

Die 7. Kalenderwoche geht zu Ende. Wir haben 17 neue Texte mit insgesamt 157.854 Zeichen veröffentlicht. Willkommen zum netzpolitischen Wochenrückblick.

Liebe Leser*innen,

Aiko, die eigentlich anders heißt, wurde von ihrem Ex-Freund gestalkt. Über ein Browser-Interface konnte er sehen, wo sie ist, was sie liest, eintippt und fotografiert. Er hat ihr Handy zur multimedialen Wanze gemacht.

Immer wieder lauert er ihr auf, hält sie fest, redet auf sie ein. Sie traut sich nicht mehr aus dem Haus. Die einst lebensfrohe junge Frau wird depressiv, durchlebt Panikattacken und Albträume.

Es gibt zahlreiche Apps, die es erlauben, die Kontrolle über fremde Telefone zu übernehmen. Die App, die Aikos Ex-Freund nutzte, kennen meine Kollegin Chris und ich schon seit einer Weile. Vor zwei Jahren haben wir uns durch Nachrichten gegraben, die Menschen aus der ganzen Welt mit dem Kundendienst der App austauschten. Sie waren in einem Datenleck öffentlich geworden und sind nun für alle nachzulesen im Internet.

In dem Leak finden sich auch Daten von Aikos Ex-Freund.

Wie brutal der Eingriff in die Privatsphäre ist, den solche Apps ermöglichen, ist mir aber erst richtig klar geworden, als ich Aiko gegenübersaß und sie uns ihre beklemmende Geschichte erzählte.

Fast unmöglich, sich der Überwachung zu entziehen

Es ist etwas anderes, sich mit der technischen Seite von Stalking zu beschäftigen als einer Person zuzuhören, die es erlebt hat. Stalking kann einen Menschen zermürben. Kommt so eine App ins Spiel, wird es für Betroffene fast unmöglich, sich der Kontrolle und Überwachung zu entziehen.

Aiko ist nur eine von vielen. Jede 100. Frau hat in den vergangenen fünf Jahren Stalking mit digitalen Tools erlebt, so eine Studie des Bundeskriminalamtes. Aiko gibt diesen vielen Frauen ein Gesicht.

Sie wollte ihre Geschichte auch deshalb erzählen, damit andere gewarnt sind. Damit andere der Software und einem Täter oder einer Täterin nicht so hilflos ausgeliefert sind wie sie. Denn eigentlich ist es ziemlich einfach, frei zugängliche Spionage-Apps zu erkennen und ihre Tätigkeit zu stoppen. Dazu muss man aber wissen, dass es sie gibt. Aikos Geschichte hilft hoffentlich dabei, dieses Wissen zu verbreiten.

Gerne weitersagen.

Martin

Degitalisierung: Großes Kino

Unsere Kolumnistin schaut sich nach Oscar-Vergleichen auf LinkedIn an, was Digitalisierung und Blockbuster-Filme gemeinsam haben – oder eben auch nicht. Denn den digitalen Verwaltungsleistungen haben die populären Filme einiges voraus. Vorhang auf! Von Bianca Kastl –

Artikel lesen

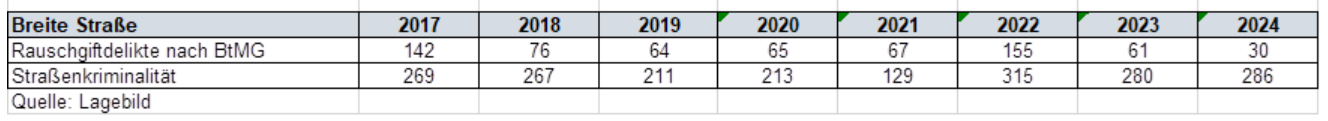

Verhaltensscanner in Mannheim: Keine Straftaten, aber Kamera-Überwachung

An Orten mit viel Kriminalität darf die Mannheimer Polizei Überwachungskameras installieren. Aber in einem Areal gab es seit Anbeginn der Videoüberwachung offenbar keine Delikte. Infolge unserer Recherchen hat sich nun die baden-württembergische Datenschutzbehörde eingeschaltet. Von Martin Schwarzbeck –

Artikel lesen

Gesetzentwurf: Vorratsdatenspeicherung deutlich länger als drei Monate

Die geplante Vorratsdatenspeicherung von IP-Adressen steht in der Kritik. Die großen Internetanbieter weisen darauf hin, dass die Pläne der Justizministerin zu vielen Monaten Speicherzwang führen würden und daher rechtswidrig sind. Doch schon die eigentlich geplanten drei Monate Speicherpflicht sind mit nichts begründet. Von Constanze –

Artikel lesen

Big-Tech-Lobbying: Erst machen, dann lieber nicht reguliert werden

Automatisch abgespielte Inhalte, personalisierte Werbung, Gamification – solche Elemente sollen Internet-Nutzer*innen heimlich beeinflussen. Dagegen soll der Digital Fairness Act helfen. Doch gegen die Pläne der EU-Kommission lobbyieren Big-Tech-Firmen wie Meta und Google, zeigt eine Untersuchung von Corporate Europe Observatory. Von Laura Jaruszewski –

Artikel lesen

Werbung auf Instagram: „Das Wort Demokratie kann problematisch sein“

Vor kurzem hat Meta auf seinen Plattformen politische Werbung verboten. Der US-Konzern will damit einer neuen Verordnung der EU trotzen. Die Maßnahme trifft nicht nur zivilgesellschaftliche Organisationen mit voller Härte, sondern kann auch Unternehmen oder Museen die Arbeit erschweren. Von Ingo Dachwitz –

Artikel lesen

Selbstbestimmungsgesetz in Baden-Württemberg: „Die automatische Datenweitergabe ist ein Skandal“

Eigentlich sollte das Selbstbestimmungsgesetz Menschen zur geschlechtlichen Selbstbestimmung verhelfen. Doch in Baden-Württemberg sollen ihre Daten nun an die Polizei übermittelt werden. Die Begründung dafür ist nicht neu. Von Timur Vorkul –

Artikel lesen

Umfrage: Hälfte der Deutschen will Verbot der Plattform X bei weiteren Rechtsverstößen

Viele Menschen sind mit ihrer Geduld mit Elon Musk und seiner Plattform X am Ende. Die Plattform hatte im Zusammenspiel mit dem Chatbot Grok zuletzt millionenfach sexualisierte Deepfakes verbreitet und ist seit der Übernahme durch den Milliardär politisch auf rechtsaußen gepolt. Von Markus Reuter –

Artikel lesen

Trotz Sicherheitsbedenken: Düsseldorfer Stadtrat will anonyme digitale Abstimmungen

Ein Online-Tool soll künftig die Arbeit des Düsseldorfer Stadtrates unterstützen. Auch anonyme Abstimmungen sind damit möglich. Für die Glaubwürdigkeit parlamentarischer Prozesse ist die Idee ein Problem. Von Martin Schwarzbeck –

Artikel lesen

Australisches Modell: „Ein Social-Media-Verbot macht den Jugendschutz schlechter“

Seit Australien Minderjährige aus sozialen Medien aussperrt, vergeht hier keine Woche ohne Forderungen nach ähnlichen Verboten. Im Interview warnt Medienrechtler Stephan Dreyer: Die politische Debatte habe sich von Forschung und Rechtslage entkoppelt. Von Sebastian Meineck –

Artikel lesen

BAMF: Über 25 Millionen Euro für eine Asyl-Blockchain

Fast die Hälfte der Asylverfahren werden mittlerweile mit Hilfe einer Blockchain verwaltet, zumindest von Registrierung bis Anhörung. Immer mehr Bundesländer nutzen das Assistenzsystem des Bundesamts für Migration und Flüchtlinge, die Behörde wird zunehmend zum Software-Anbieter. Von Anna Biselli –

Artikel lesen